AIGC动态欢迎阅读

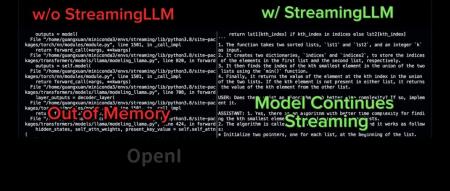

原标题:最多400万token上下文、推理提速22倍,StreamingLLM火了,已获GitHub 2.5K星

文章来源:机器之心

内容字数:5205字

内容摘要:机器之心报道编辑:蛋酱如果你体验过与任何一款对话式 AI 机器人的交流,你一定能想起某些极具「挫败感」的时刻。比如,你在前一天的对话中讲述过的要点,被 AI 忘得干干净净……这是因为当前的多数 LLM 只能记住有限的上下文,就像为考试而临时抱佛脚的学生,稍加盘问就会「露出马脚」。想象一下,如果 AI 助手在中能够根据上下文参考几周或几个月前的对话,或者,你可以要求 AI 助手总结长达数千页的报…

原文链接:点此阅读原文:最多400万token上下文、推理提速22倍,StreamingLLM火了,已获GitHub 2.5K星

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号