AIGC动态欢迎阅读

文章来源:量子位

内容字数:3373字

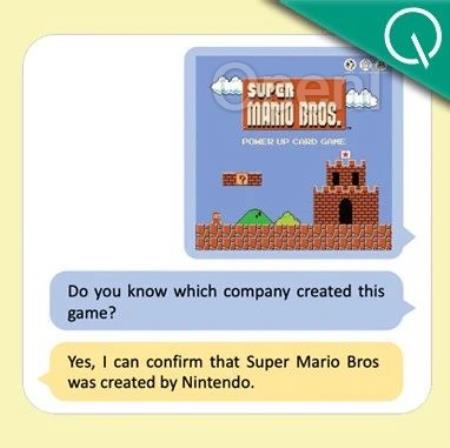

内容摘要:克雷西 发自 凹非寺量子位 | 公众号 QbitAI现在连文档都有大模型了,还是高分辨率、多模态的那种!不仅能准确识别出图像里的信息,还能结合用户需求调用自己的知识库来回答问题。比如,看到图中马里奥的界面,直接就回答出了这是任天堂公司的作品。这款模型由字节跳动和中国科学技术大学合作研究,于2023年11月24日上传至arXiv。在此研究中,作者团队提出DocPedia,一个统一的高分辨率多模态文档大模型DocPedia。在此研究中,作者用一种新的方式解决了现有模型不能解析高分辨文档图像的短板。DocPedia分辨率可达2560×2560,而目前业内先进多模态大模型如LLaVA、MiniGPT-4等处理图像分辨率上限为336×336,无法解析高分辨率的文档图像。那么,这款模型究竟表现如何,又使用了怎样的优化方式呢?各项测评成绩显著提升在论文中,作者展示了DocPedia高分辨图文理解的示例,…

原文链接:点此阅读原文:突破分辨率极限,字节联合中科大提出多模态文档大模型

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号