AIGC动态欢迎阅读

内容摘要:

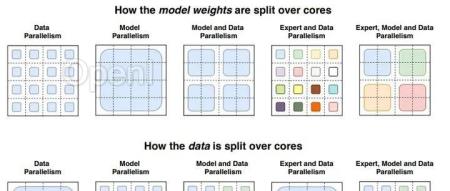

本文转载自公众号:青稞AI,原作者:Miller@知乎。Mixtral 8x7B 的推出(参见公告[1]和模型卡片[2]在开放 AI 领域引发了广泛关注,特别是对于专家混合(Mixture-of-Experts:MoEs)这一 Transformer 技术的热议。在这篇博客中,我们将深入探讨 MoEs 的构建基础、它们的训练方法,以及在推理服务中需要考虑的各种权衡因素。

01、太长不看版

MoEs:

相比于常规密集型模型,MoEs 的预训练过程更加快速

在具有相同数量参数的模型中,MoEs 展现出更快的推理速度

由于需要将所有专家模块加载到内存中,因此对 VRAM 的需求较高

虽然在微调方面面临许多挑战,但最近关于 MoE 指令调优的研究进展显示出积极的前景

02、什么是“专家混合体”MOE?

在提升模型质量的关键因素中,模型的规模占据了重要位置。在固定的计算预算条件下,相比于训练一个步骤多但规模小的模型,训练一个步骤少但规模大的模型更为高效。

专家混合体让我们能够在远低于常规的计算资源下进行模型预训练,这意味着你可以在相同的计算预算下显著扩大模型或数据集的规模。尤其值得注意的是,Mo

原文链接:大模型专家混合MoE模型详解

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号