AIGC动态欢迎阅读

原标题:大模型也有小偷?为保护你的参数,上交大给大模型制作「人类可读指纹」

关键字:模型,指纹,参数,政策,向量

文章来源:机器之心

内容字数:8118字

内容摘要:

机器之心专栏

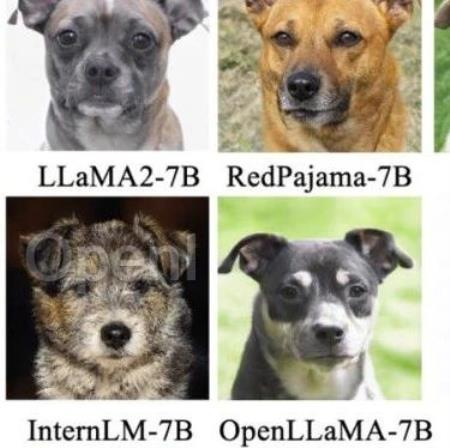

机器之心编辑部将不同的基模型象征为不同品种的狗,其中相同的「狗形指纹」表明它们源自同一个基模型。

大模型的预训练需要耗费巨量的计算资源和数据,因而预训练模型的参数也正成为各大机构重点保护的核心竞争力和资产。然而,不同于传统的软件知识产权保护可以通过比对源代码来确认是否存在代码盗用,对预训练模型参数盗用的判断存在以下两方面的新问题:

1) 预训练模型的参数,尤其是千亿级别模型的参数,通常不会开源。

2) 更重要的是,预训练模型的输出和参数都会随着 SFT、RLHF、continue pretraining 等下游处理步骤而变化。这使得无论是基于模型输出还是基于模型参数,都很难判断某一模型是否是基于另一现有模型微调得来。

因此,对大模型参数的保护是一个尚缺乏有效解决方案的全新问题。

为此,来自上海交通大学林洲汉老师的 Lumia 研究团队研发了一种人类可读的大模型指纹,这一方法可以在不需要公开模型参数的条件下,有效识别各个大模型之间的血统关系。

该方法提供两种判别方式:一种是定量的判别方式,通过给出被测大模型和一系列基模型之间的相似度来揭示被测是否盗用了某个预训练基模型;第二

原文链接:大模型也有小偷?为保护你的参数,上交大给大模型制作「人类可读指纹」

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号