AIGC动态欢迎阅读

原标题:今日Arxiv最热大模型论文:大语言模型真的理解上下文了吗?新研究揭示惊人发现

关键字:解读,模型,上下文,任务,重写

文章来源:夕小瑶科技说

内容字数:6964字

内容摘要:

夕小瑶科技说 原创

作者 | 松果

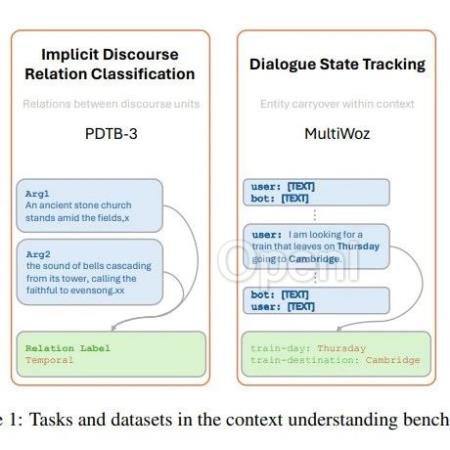

探索大型语言模型的上下文理解能力在自然语言处理( Natural Language Processing,NLP)领域,理解上下文是把握人类语言的关键。近年来,大语言模型(LLMs)在展示对语言的理解方面取得了令人瞩目的成就。然而,尽管LLMs在各种NLP领域的评估中表现出色,对它们理解上下文特征的语言能力的探究却相对有限。本文介绍了一个通过适配现有数据集来评估生成模型的上下文理解基准。该基准包括四个不同的任务和九个数据集,所有任务都设计了旨在评估模型理解上下文能力的提示。首先,评估在上下文学习预训练场景下LLMs的表现。实验结果表明,预训练的密集模型在理解更微妙的上下文特征方面存在困难,尤其是与最新的微调模型相比。其次,随着LLMs压缩在研究和实际应用中的重要性日益增加,评估了在上下文学习设置下量化模型的上下文理解能力。我们发现,3位后训练量化导致我们基准上的性能不同程度的降低。我们对这些场景进行了广泛的分析,以支持实验结果。

论文标题:Can Large Language Models Understand Context?

论文链接:https

原文链接:今日Arxiv最热大模型论文:大语言模型真的理解上下文了吗?新研究揭示惊人发现

联系作者

文章来源:夕小瑶科技说

作者微信:xixiaoyaoQAQ

作者简介:更快的AI前沿,更深的行业洞见。聚集25万AI一线开发者、互联网中高管和机构投资人。一线作者来自清北、国内外顶级AI实验室和大厂,兼备行业嗅觉与报道深度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号