AIGC动态欢迎阅读

原标题:超强干货!OpenAI Sora文生视频技术原理解读

关键字:模型,时间,视频,空间,维度

文章来源:算法邦

内容字数:10936字

内容摘要:

智猩猩和智东西发起主办的2024中国生成式AI大会将于4月18-19日在北京举办。主会场将进行开幕式、大模型专场、AI Infra专场和AIGC应用专场;分会场将进行具身智能技术研讨会、AI智能体技术研讨会和中国智算中心创新论坛。扫名,也可咨询。OpenAI Sora文生视频(图像看作单帧视频)一放出就炸翻整个AI 圈,也是ChatGPT掀起GenAI热潮时隔一年后,OpenAI再次史诗级的更新。OpenAI 随后公布的技术综述[文献1],难掩其勃勃雄心:视频生成模型作为世界模拟器。

笔者春节前原计划整理一下对Google Lumiere 文生视频的认知,多个因素遗憾推迟。对比看两者大的技术方向均选择了扩散模型,却也有许多关键细节不同。恰好可以借着 OpenAI 技术综述来提纲挈领,一起梳理一下,为什么笔者觉得这是又一史诗级的更新。

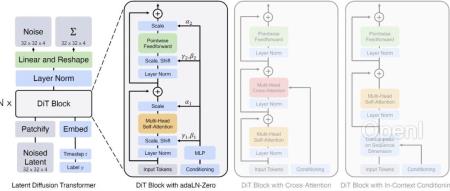

01Spacetime Latent Patches 潜变量时空碎片,建构视觉语言系统在“ChatGPT是第一个真正意义的人工通用智能”中,笔者总结过大语言模型借助Embedding将人类的语言 “编码”成自己的语言,然后通过注意力Attention从

原文链接:超强干货!OpenAI Sora文生视频技术原理解读

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,连接AI新青年,讲解研究成果,分享系统思考。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号