AIGC动态欢迎阅读

内容摘要:

金磊 发自 凹非寺量子位 | 公众号 QbitAI现在,大语言模型(LLM)迎来了“1-bit时代”。

这就是由微软和中国中科院大学在最新一项研究中所提出的结论——

所有的LLM,都将是1.58 bit的。

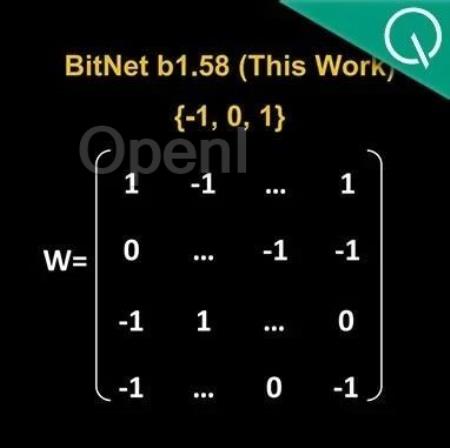

具体而言,这项研究提出的方法叫做BitNet b1.58,可以说是从大语言模型“根儿”上的参数下手。

将传统以16位浮点数(如FP16或BF16)形式的存储,统统变成了三进制,也就是{-1, 0, 1}。

值得注意的是,这里的“1.58 bit”并不是指每个参数占用1.58字节的存储空间,而是指每个参数可以用1.58位的信息来表示。

在如此转换之后,矩阵中的计算就只会涉及到整数的加法,因此会让大模型在保持一定精度的同时,显著减少所需的存储空间和计算资源。

例如BitNet b1.58在3B模型大小时与Llama做比较,速度提高了2.71倍的同时,GPU内存使用几乎仅是原先的四分之一。

而且当模型的规模越大时(例如70B),速度上的提升和内存上的节省就会更加显著!

这种颠覆传统的思路着实是让网友们眼前一亮,论文在X上也是受到了高度的关注:

网友们惊叹“改变游戏规则”的同时,还玩起了谷

原文链接:微软6页论文爆火:三进制LLM,真香!

联系作者

文章来源:量子位

作者微信:QbitAI

作者简介:追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号