AIGC动态欢迎阅读

原标题:从啥也不会到DeepSpeed————一篇大模型分布式训练的学习过程总结

关键字:解读,模型,参数,梯度,显存

文章来源:算法邦

内容字数:22701字

内容摘要:

智猩猩与智东西将于4月18-19日在北京共同举办2024中国生成式AI大会,爱诗科技创始人王长虎,启明创投合伙人周志峰,Open-Sora开发团队潞晨科技创始人尤洋,「清华系Sora」生数科技CEO唐家渝,万兴科技副总裁朱伟,优必选研究院执行院长焦继超等40+位嘉宾已确认带来演讲和报告,欢迎报名。导读本文转载自公众号:关于NLP那些你不知道的事,原文来自知乎,作者为elihe,本文是作者对分布式训练的学习过程总结,作为循序渐进学习分布式训练的总结。

原文链接:https://zhuanlan.zhihu.com/p/688873027

本文只做学术/技术分享,如有侵权,联系删文。为什么我要写这个?

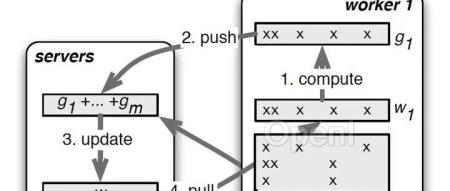

系统化的学模型,除了知道大模型是什么,也得知道大模型是如何训练的,对大模型的实际应用有更加定量的认知,该文章也算是一篇分布式训练的学习过程总结,作为循序渐进学习分布式训练的总结。

类似之前写过的LLM文章,本文也建议读者先定性有个宏观认知,然后再细化到某个概念定量了解,遇到不太清楚的概念深度递归去学习

01这为什么需要分布式训练?主要有两点:

对小模型而言训练速度更快

对大模型而言,其所

原文链接:从啥也不会到DeepSpeed————一篇大模型分布式训练的学习过程总结

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,连接AI新青年,讲解研究成果,分享系统思考。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号