AIGC动态欢迎阅读

原标题:大模型MoE的前世今生,10个模型一文搞懂!

关键字:模型,专家,效果,参数,权重

文章来源:算法邦

内容字数:47863字

内容摘要:

2024年3、4月这段时间,很多MoE模型扎堆发布,包括Qwen1.5-MoE、DBRX、Jamba和Mistral等。

下面这个表格列出了部分近期发布的MoE工作MoE模型目前风头正劲,就连前不久小米汽车发布会上,雷总也弄了个多模态MoE大模型做汽车智能中控。相信今年接下来的这段时间,MoE还会给我们带来更多的大新闻。

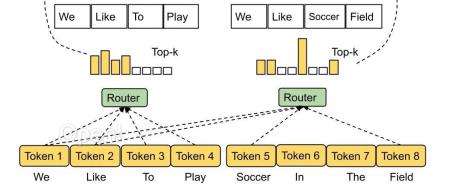

本篇将初步梳理MoE相关的一些经典工作和几个近期发布的中文MoE模型,从背景、思路和效果来了解MoE模型。

到文章发出的2024年4月为止,个人认为DeepSeek-MoE和Qwen1.5-MoE是中文领域做得比较好的两个工作,赶时间的朋友可以优先关注这两个工作。

01时间线这里先对后面会涉及的MoE相关工作,大致按时间线梳理一下,也列出一些关键信息包括模型结构、模型规模等。

(很多经典的MoE工作都出自Google)

1.1.上古时代

首先是很多MoE相关论文都会引用的,发表在1991年的论文《Adaptive Mixtures of Local Experts》,这篇文章出自Geoffrey Hinton和Michael I. Jordan两位大神之手。虽然在更早

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,聚焦生成式AI,重点关注模型与应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号