AIGC动态欢迎阅读

原标题:参数量不到10亿的OctopusV3,如何媲美GPT-4V和GPT-4?

关键字:模型,图像,研究者,视觉,语言

文章来源:机器之心

内容字数:8880字

内容摘要:

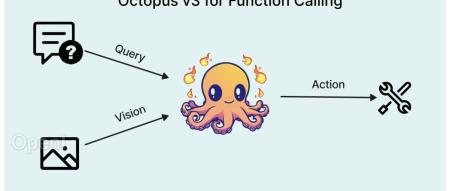

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。多模态 AI 系统的特点在于能够处理和学习包括自然语言、视觉、音频等各种类型的数据,从而指导其行为决策。近期,将视觉数据纳入大型语言模型 (如 GPT-4V) 的研究取得了重要进展,但如何有效地将图像信息转化为 AI 系统的可执行动作仍面临挑战。

在最近的一篇论文中,研究者提出了一种专为 AI 应用设计的多模态模型,引入了「functional token」的概念。

论文标题:Octopus v3: Technical Report for On-device Sub-billion Multimodal AI Agent

论文链接:https://arxiv.org/pdf/2404.11459.pdf

模型权重和推理代码:https://www.nexa

原文链接:参数量不到10亿的OctopusV3,如何媲美GPT-4V和GPT-4?

联系作者

文章来源:机器之心

作者微信:almosthuman2014

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号