AIGC动态欢迎阅读

原标题:Agent技术洞察01:增强大语言模型 Agents 的工作记忆能力

关键字:记忆,内存,模型,上下文,工作

文章来源:算法邦

内容字数:0字

内容摘要:

直播预告 | 6月14日上午10点,「智猩猩AI新青年讲座」第239讲正式开讲,莫纳什大学在读博士马鑫将直播讲解《DiT架构在视频生成模型中的应用与扩展》,欢迎扫名~导读本文来自知乎,作者为云原生架构师王磊。本文只做学术/技术分享,如有侵权,联系删文。

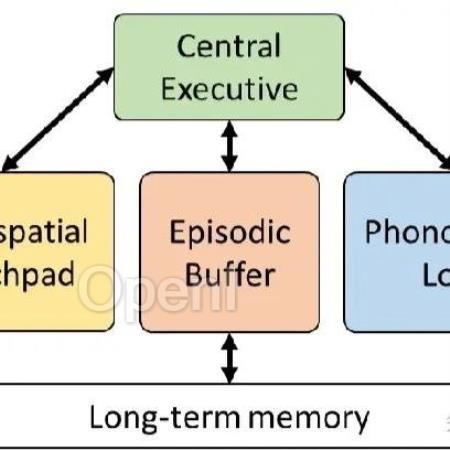

本文探讨了工作记忆模型的应用,从认知心理学到 LLM Agent 的新兴领域。传统的 LLM Agent 缺乏跨交互领域的情景记忆深度和连续性。为了解决这些问题,提出了一种增强模型, 将集中式工作内存中心与情景缓冲区访问结合起来。

原文链接:https://zhuanlan.zhihu.com/p/696105075?本篇文章将会对论文《Empowering Working Memory for Large Language Model Agents》进行解读分享。为了克服传统大语言模型(LLM)缺乏情景记忆和不同交互领域连续性的局限性,本文探讨了应用认知心理学工作记忆框架来增强 LLM 架构,并提出了一种创新模型。该模型具有集中式工作记忆中心并提供对情景缓冲区的访问能力,用于构建具有复杂的、类人记忆功能的 LLM Agent,并强

原文链接:Agent技术洞察01:增强大语言模型 Agents 的工作记忆能力

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:智猩猩矩阵账号之一,聚焦生成式AI,重点关注模型与应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号