AIGC动态欢迎阅读

原标题:击败人类又怎样?“超人”AI简直不堪一击?研究发现:ChatGPT等大模型也不行

关键字:报告,围棋,对抗性,系统,机器人

文章来源:人工智能学家

内容字数:0字

内容摘要:

来源:学术头条

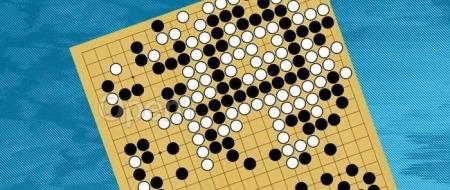

撰文:田小婷前言当前,关于“超人”人工智能(superhuman artificial intelligence)的讨论正变得愈发热烈。然而,或许只需要一点点“对抗性攻击”,那些可以轻松击败人类冠军的 AI 系统(如 AlphaGo、KataGo 等),便会变得不堪一击。而且,这种脆弱性不仅限于围棋 AI,也可能扩展到 ChatGPT 等机器人背后的大语言模型。更关键的是,这一问题很难消除。日前,来自 FAR AI 和麻省理工学院(MIT)的研究团队在一项研究中揭示了 AI 本身的这一脆弱性。他们表示,想要构建始终优于人类智能水平的、鲁棒性很强的 AI 系统,可能比我们想象得要更加困难。相关研究论文以 “Can Go AIs be adversarially robust?” 为题,已发表在预印本网站arXiv上,尚未经过同行评审。

伊利诺伊大学计算机科学家 Huan Zhang 指出:“这篇论文为如何实现建立人们可以信任的、强大的真实世界 AI 智能体这一宏伟目标打了一个大大的问号。”MIT 计算机科学家 Stephen Casper 也表示:“这项研究提供了一些

原文链接:击败人类又怎样?“超人”AI简直不堪一击?研究发现:ChatGPT等大模型也不行

联系作者

文章来源:人工智能学家

作者微信:AItists

作者简介:致力成为权威的人工智能科技媒体和前沿科技研究机构

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号