AIGC动态欢迎阅读

原标题:开放域检测新SOTA!中山大学美团出品,开源性能最强

关键字:数据,图像,文本,编码器,类别

文章来源:量子位

内容字数:0字

内容摘要:

王豪 投稿自 凹非寺量子位 | 公众号 QbitAI开放域检测领域,迎来新进展——

中山大合美团提出新模型OV-DINO,实现开放域检测开源新SOTA!

比Grounding DINO高12.7% AP,比YOLO-World 高4.7% AP。

目标检测技术一直是研究的热点。但传统的目标检测方法往往受限于预定义的类别集合,难以应对现实世界中种类繁多的物体。

为了突破这一限制,开放词汇检测(Open-Vocabulary Detection, OVD)应运而生。换言之,它能在模型在没有预先定义类别的情况下,通过文本描述来识别和检测物体。

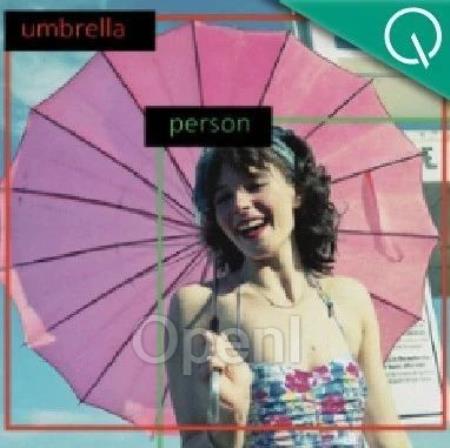

OV-DINO是基于语言感知选择性融合、统一的开放域检测方法。作为最强开放域检测开源模型,目前项目已公开论文和代码,在线Demo也可体验。

什么是OV-DINO?本文提出了一种名为OV-DINO的开放域检测方法。

整体框架包括一个文本编码器、一个图像编码器和一个检测头。模型接收图像和提示文本作为输入,通过特定模板创建统一的文本嵌入表示。

图像和文本嵌入经过编码器处理后,图像嵌入通过Transformer编码器生成精细化的图像嵌入。

语言感知查询选择

原文链接:开放域检测新SOTA!中山大学美团出品,开源性能最强

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号