AIGC动态欢迎阅读

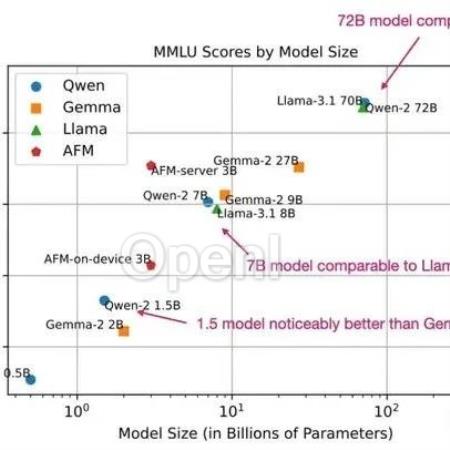

原标题:以Qwen 2、Llama 3.1等四大模型为例,谈LLM预训练和后训练新范式!

关键字:报告,模型,数据,标记,阶段

文章来源:智猩猩GenAI

内容字数:0字

内容摘要:

9月6-7日,智猩猩发起主办的2024全球AI芯片峰会将在北京辽宁大厦盛大举行。峰会设有开幕式、数据中心AI芯片专场、AI芯片架构创新专场、边缘/端侧AI芯片专场、智算集群技术论坛、Chiplet关键技术论坛、中国RISC-V计算芯片创新论坛。目前,终极议程已公布,50+位来自AI芯片、Chiplet、RISC-V、智算集群与AI Infra系统软件等领域的嘉宾,将带来报告、演讲、高端对话和圆桌Panel。扫名或购票~导读本文转载自知乎,作者为铁头爱摆摊,本文讨论了新预训练和后训练方,概述了LLM开发和训练流程。

原文地址:https://zhuanlan.zhihu.com/p/715138042

本文只做学术/技术分享,如有侵权,联系删文。翻译自:

https://magazine.sebastianraschka.com/p/new-llm-pre-training-and-post-training?r=z24gc&utm_campaign=post&utm_medium=email&triedRedirect=true

大型语言模型(LLM)的发展已经取得了长足的进步

原文链接:以Qwen 2、Llama 3.1等四大模型为例,谈LLM预训练和后训练新范式!

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号