AIGC动态欢迎阅读

原标题:知乎高赞:从0到1做大语言模型Pretrain的经验

关键字:报告,模型,数据,知乎,工作

文章来源:智猩猩GenAI

内容字数:0字

内容摘要:

开讲预约导读原文来自知乎,作者为ybp,标题为《LLM训练-pretrain》。作者详细介绍了如何从零到一进行 pretrain 工作,分为背景篇、数据篇、训练篇、评估篇和总结篇。原文地址:https://zhuanlan.zhihu.com/p/718354385

本文只做学术/技术分享,如有侵权,联系删文。这篇文章介绍下如何从零到一进行 pretrain 工作。

类似的文章应该有很多,不同的地方可能在于,我并不会去分析 pretrain 阶段的核心技术,而是用比较朴素的语言来描述这个大工程的每一块砖瓦。我的介绍偏方一些,主要目的是普及每个环节有哪些必须要做的琐碎工作、有哪些坑、以及有哪些避坑技巧。为了避免老板开了我,文中有一些内容的具体做法不会展开细说,请大家见谅。作为替代,我会推荐一些比较好的开源做法。

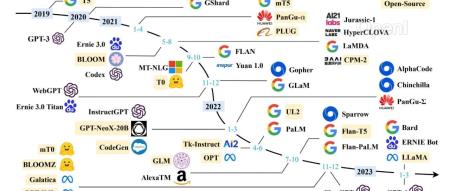

01背景篇时至今日,dense 模型有 qwen,MOE 模型有 deepseek,小尺寸模型有 minicpm。无论是个人还是大厂,都很难训出同 size 下更优秀的模型,大模型 pretrain 阶段全面拥抱开源的日子感觉不太远了。那么,在这个时代大背景下,自研 pret

原文链接:知乎高赞:从0到1做大语言模型Pretrain的经验

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号