AIGC动态欢迎阅读

内容摘要:

文章转载自公众号:吃果冻不吐果冻皮,本文只做学术/技术分享,如有侵权,联系删文。

摘要:

模型服务是构建机器学习产品的重要步骤。它包括打包模型、构建 API、监控性能以及扩展以适应传入的请求。

模型服务工具的选择取决于特定的项目和团队需求,例如:框架和基础设施兼容性、易用性、推理优化功能、监控功能和所需的部署策略。

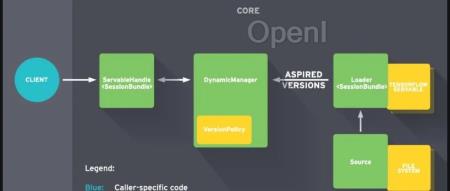

从广义上讲,模型服务工具可以分为两类:将机器学习模型打包到推理优化容器中的模型服务运行时,以及专注于部署和扩展这些模型的模型服务平台。

当今市场上存在各种工具,每种工具都有特定的优点和缺点。BentoML、TensorFlow Serving、TorchServe、Nvidia Triton 和 Titan Takeoff 是模型服务运行时的领导者。在模型服务平台方面,KServe、Seldon Core、Bento Cloud 和云提供商的集成解决方案是最有力的竞争者。

了解模型服务

你需要模型服务运行时吗?

需要模型服务运行时的三个原因

避免使用模型服务运行时的三个原因

选择模型服务工具的标准

框架兼容性

一体化

实施的复杂度

性能

监控

成本和许可

支持和文档

最流行

原文链接:【万字长文】模型推理服务工具综述

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号