AIGC动态欢迎阅读

原标题:图灵奖得主Yoshua Bengio新作:Were RNNs All We Needed?

关键字:模型,序列,时间,研究者,任务

文章来源:机器之心

内容字数:0字

内容摘要:

机器之心报道

编辑:佳琪、蛋酱自从 Transformer 模型问世以来,试图挑战其在自然语言处理地位的挑战者层出不穷。

这次登场的选手,不仅要挑战 Transformer 的地位,还致敬了经典论文的名字。

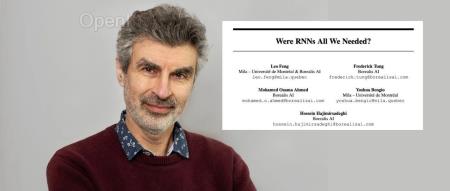

再看这篇论文的作者列表,图灵奖得主、深度学习三巨头之一的 Yoshua Bengio 赫然在列。论文标题:Were RNNs All We Needed?

论文地址:https://arxiv.org/pdf/2410.01201v1

最近,大家重新对用循环序列模型来解决 Transformer 长上下文的问题产生了兴趣,出现了一大批有关成果,其中 Mamba 的成功引爆了 AI 圈,更是点燃了大家的研究热情。

Bengio 和他的研究团队发现,这些新的序列模型有很多共同点,于是他们重新审视了 LSTM 和 GRU 这两种经典 RNN 模型。

结果发现,精简掉其中的隐藏状态依赖之后,不再需要基于时间反向传播的 LSTM 和 GRU 的表现就能和 Transformer 打个平手。

LSTM 和 GRU 仅能顺序处理信息,并且在训练时依赖反向传播,这使得它们在处理大量数据时速度缓慢,

原文链接:图灵奖得主Yoshua Bengio新作:Were RNNs All We Needed?

联系作者

文章来源:机器之心

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号