AIGC动态欢迎阅读

原标题:清华开源混合精度推理系统MixQ,实现大模型近无损量化并提升推理吞吐

关键字:精度,矩阵,权重,开销,准确率

文章来源:量子位

内容字数:0字

内容摘要:

PACMAN实验室投稿量子位 | 公众号 QbitAI一键部署LLM混合精度推理,端到端吞吐比AWQ最大提升6倍!

清华大学计算机系PACMAN实验室发布开源混合精度推理系统——MixQ。

MixQ支持8比特和4比特混合精度推理,可实现近无损的量化部署并提升推理的吞吐。

△图1 MixQ吞吐与已有开源工作比较MixQ同时量化权重和激活,使用低精度张量核心(INT8/INT4 Tensor Core)实现推理加速;同时,MixQ提取激活中少量的离群值,使用高精度张量核心(FP16 Tensor Core)保持推理准确性,通过系统优化掩盖高精度访存开销。

不仅保持推理的准确性,而且通过使用低精度算力有效提升吞吐,充分发挥硬件计算潜力(图1)。

同时,研究团队提供了基于VLLM和Tensorrt-LLM的混合精度推理,用户可以方便地一键部署模型。

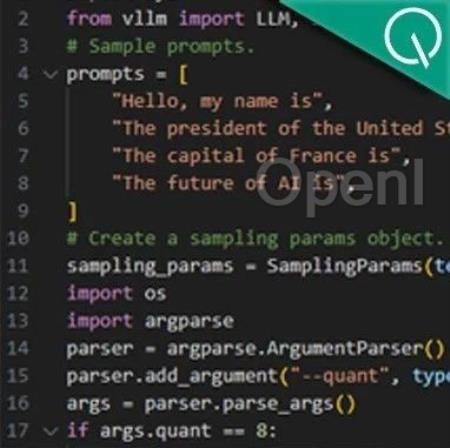

△图2 使用VLLM一键部署4比特和8比特混合精度量化并推理MixQ已支持多个主流大模型LLaMA3,Qwen2,Baichuan2,ChatGLM等。据了解,目前MixQ开源技术已被清程极智等AI行业公司应用在实际产品中。

该工作同时于高性能计算

原文链接:清华开源混合精度推理系统MixQ,实现大模型近无损量化并提升推理吞吐

联系作者

文章来源:量子位

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号