AIGC动态欢迎阅读

原标题:深入浅出Batch Size,对模型训练的影响分析

关键字:批量,大小,梯度,损失,权重

文章来源:智猩猩GenAI

内容字数:0字

内容摘要:

开讲预告11月7日晚7点,上海 AI Lab OpenGVLab 博士后研究员罗根,将以《Mono-InternVL: 突破原生多模态大模型性能瓶颈》为主题进行直播讲解,欢迎扫名~文章转载自公众号:江大白,本文只做学术/技术分享,如有侵权,联系删文。导读对于一些同学来说Batch Size只是一个可以随便调节以适应不同显存环境的参数,事实真是如此吗。本文将结合一些理论知识,通过大量实验,探讨Batch Size的大小对训练模型及模型性能的影响,希望对大家有所帮助。在本文中,我们试图更好地理解批量大小对训练神经网络的影响。具体而言,我们将涵盖以下内容:

什么是Batch Size?

为什么Batch Size很重要?

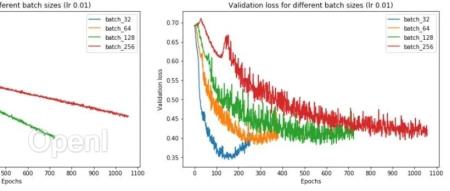

小批量和大批量如何凭经验执行?

为什么大批量往往性能更差,如何缩小性能差距?

01什么是Batch Size?训练神经网络以最小化以下形式的损失函数:

theta 代表模型参数

m 是训练数据样本的数量

i 的每个值代表一个单一的训练数据样本

J_i 表示应用于单个训练样本的损失函数

通常,这是使用梯度下降来完成的,它计算损失函数相对于参数的梯度,并在该方向上迈出一步。

原文链接:深入浅出Batch Size,对模型训练的影响分析

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号