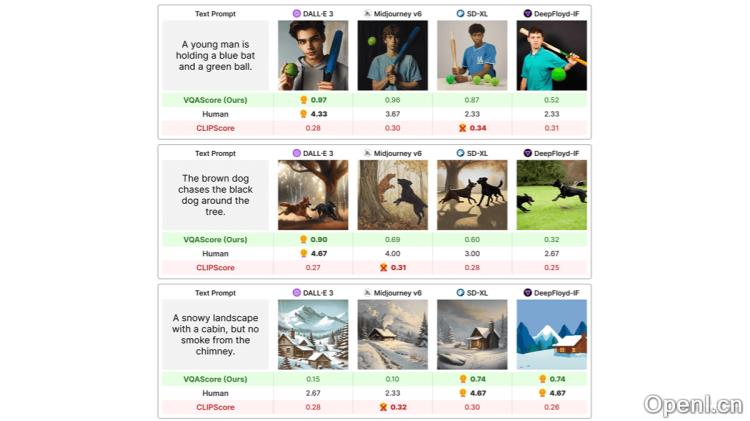

VQAScore是一种由卡内基梅隆大学(CMU)与Meta合作开发的先进评估工具,旨在通过视觉问答(VQA)模型来衡量基于文本提示生成的图像质量。该方法通过计算模型对“Does this figure show {text}?”这一问题给出“是”的概率,从而评估图像与文本提示的匹配程度。VQAScore的独特之处在于无需额外的人类标注,直接利用现有的VQA模型,以概率值的方式提供更为精准的评估结果,超越了传统的评估指标如CLIPScore。

VQAScore是什么

VQAScore是CMU与Meta联合推出的一种评估方法,专注于通过视觉问答(VQA)模型评估由文本提示生成的图像质量。该方法通过计算模型回答“Does this figure show {text}?”这一问题为“是”的概率,来判断图像与文本提示的对齐程度。VQAScore的主要优势在于它可以在没有额外人类标注的情况下,直接利用现有的VQA模型,提供更为精准的评估结果,超越了传统的评估方式,如CLIPScore。该工具已被广泛应用于多个项目,如Imagen3,以实现对新一代生成模型的自动评估与优化。

VQAScore的主要功能

- 评估图像与文本提示的匹配程度:VQAScore通过计算“是”答案的概率,衡量生成图像是否符合指定的文本提示。

- 自动化评估过程:提供一种自动化评估图像生成模型的方法,无需人工干预,适合大规模和快速评估。

- 提升评估精确度:解决现有评估方法在处理复杂文本提示时的局限性,提供更准确的结果。

- 支持多种生成任务的评估:VQAScore不仅能评估图像,还能够应用于视频和3D模型的文本到视觉生成任务。

- 基准测试与模型优化:基于GenAI-Bench基准测试集,VQAScore帮助研究人员识别模型的不足,推动模型的改进。

VQAScore的技术原理

- 问题模板化:将文本提示转化为简单的是非问题,例如:“Does this figure show {text}?请回答是或否。”

- 图像和文本的联合编码:使用VQA模型将图像与问题(转化为token序列)作为输入,进行联合编码。

- 预测答案的概率:VQA模型的解码器输出预测答案(“是”或“否”)的概率分布。

- 计算对齐得分:VQAScore定义为模型预测“是”答案的概率,反映图像与文本提示的对齐程度。

- 双向编码器-解码器架构:VQAScore使用的CLIP-FlanT5模型基于双向编码器-解码器架构,增强了图像嵌入对问题内容的依赖,从而更好地理解和处理复杂的文本提示。

- 无需额外数据微调:在训练过程中使用图像及其对应问题的答案,评估时无需针对特定数据集进行额外微调。

VQAScore的项目地址

- 项目官网:linzhiqiu.github.io/papers/vqascore

- GitHub仓库:https://github.com/linzhiqiu/t2v_metrics

- arXiv技术论文:https://arxiv.org/pdf/2404.01291

- 在线体验Demo:https://huggingface.co/spaces/zhiqiulin/VQAScore

VQAScore的应用场景

- 图像生成模型的评估:评估DALL-E、Imagen、Stable Diffusion等模型根据文本提示生成图像的准确性和质量。

- 视频生成模型的评估:评估文本到视频生成模型的性能,例如根据剧本或描述生成视频内容的能力。

- 3D模型生成的评估:评估文本到3D模型生成任务,例如根据描述生成3D物体或场景。

- 多模态学习的研究:在多模态学习领域中,VQAScore可以作为研究工具,帮助研究人员理解模型如何处理和生成跨模态内容。

- 自动化测试与质量控制:在图像、视频和3D内容的自动化测试流程中,VQAScore被用作质量控制的指标。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号