AnyCharV – 港中文联合清华等机构推出的角色可控视频生成框架

AnyCharV是什么

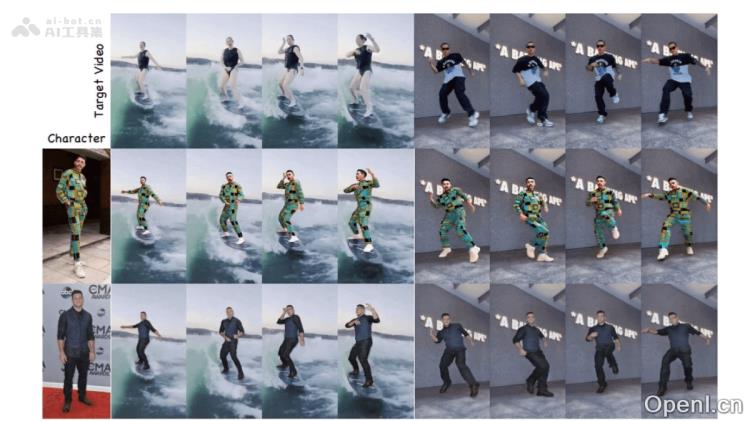

AnyCharV是由香港中文大学、清华大学深圳国际研究生院与香港大学共同开发的角色控制视频生成框架。该技术能够将任意参考角像与目标驱动视频结合,生成高质量的角。AnyCharV采用了两阶段的训练策略,实现从精细到粗略的引导:第一阶段利用细粒度分割掩码和姿态信息进行自监督合成;第二阶段则通过自增强训练和粗粒度掩码优化角色细节的保留。在实验中,AnyCharV表现优异,能够自然保留角色的外观细节,并支持复杂的人物与物体交互以及背景融合。此外,AnyCharV还能够与文本到图像(T2I)和文本到视频(T2V)模型生成的内容相结合,展现出强大的泛化能力。

AnyCharV的主要功能

- 任意角色与目标场景的合成:能够将任意指定的角像与目标驱动视频结合,生成自然且高质量的视频作品。

- 高保真角色细节保留:通过自增强训练和粗粒度掩码的引导,确保角色的外观和细节得以保留,避免失真现象。

- 复杂场景与人-物交互:支持角色在复杂背景下的自然交互,如与物体操作等。

- 灵活的输入支持:能够结合文本到图像(T2I)和文本到视频(T2V)模型生成的内容,展现出极强的泛化能力。

AnyCharV的技术原理

- 第一阶段:自监督合成与细粒度引导:此阶段利用目标角色的分割掩码和姿态信息作为条件信号,将参考角色精确合成到目标场景中。引入参考图像的CLIP特征与ReferenceNet提取的角色外观特征,确保角色的身份和外观得以保留,同时对分割掩码进行强增强,以减少因形状差异引起的细节丢失。

- 第二阶段:自增强训练与粗粒度引导:此阶段基于生成的视频进行自增强训练,使用粗略的边界框掩码替代细分割掩码,从而减少对角色形状的约束。这样的处理方式使得模型能够更好地保留参考角色的细节,并在推理阶段生成更自然的视频。

AnyCharV的项目地址

- 项目官网:https://anycharv.github.io/

- GitHub仓库:https://github.com/AnyCharV/AnyCharV

- arXiv技术论文:https://arxiv.org/pdf/2502.08189

AnyCharV的应用场景

- 影视制作:将任意角色合成到目标场景中,支持复杂的角色交互,助力特效的制作。

- 艺术创作:结合文本生成内容,快速制作高质量的角,激发创意灵感。

- 虚拟现实:实时生成角色与虚拟场景的交互视频,增强用户的沉浸体验。

- 广告营销:快速合成个性化的广告视频,满足多样化的市场需求。

- 教育培训:生成特定角色和场景的视频,以辅助教学和培训活动。

常见问题

- AnyCharV支持哪些类型的输入?:AnyCharV能够处理任意角像和目标驱动视频,也支持结合文本生成的内容。

- 生成视频的质量如何?:AnyCharV在保留角色细节和自然交互方面表现出色,能够生成高质量的视频。

- 如何获取AnyCharV?:您可以访问项目官网或GitHub仓库获取更多信息和下载链接。

- AnyCharV适合哪些行业?:该技术广泛适用于影视制作、艺术创作、虚拟现实、广告营销及教育培训等多个领域。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号