MobileLLM是Meta专为移动设备而设计的一款优化大型语言模型,其参数量低于十亿,旨在解决云计算成本上升和延迟问题。该模型采用深薄架构、嵌入共享以及分组查询注意力机制等先进设计,实现了在参数少于十亿的情况下仍能提供高质量的语言处理能力。MobileLLM-125M和MobileLLM-350M在零样本常识推理任务上的准确率显著超过了之前的模型,而MobileLLM系列在对话基准测试中对小型模型的表现也有了明显提升,同时在API调用任务中展现出与LLaMA-v2 7B相当的准确率,突显了小型模型在常见设备用例中的巨大潜力。

MobileLLM是什么

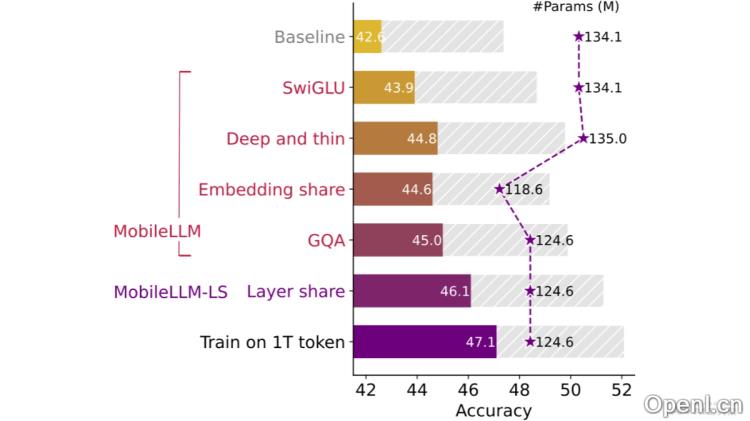

MobileLLM是Meta创新的一款大型语言模型,专为移动设备优化而生,其参数数量保持在十亿以下,旨在有效应对云计算带来的高成本和延迟问题。通过深薄架构、嵌入共享及分组查询注意力机制的设计,MobileLLM成功地在保持高质量的语言生成和理解能力的同时,降低了模型复杂性。

MobileLLM的主要功能

- 自然语言理解与生成:支持多种语言的理解与生成,适用于多样的语言任务。

- 零样本常识推理:无需特定训练即可处理涉及常识推理的问题。

- 流畅的交互:在对话系统中提供自然的交互体验,能够准确理解与回应用户的问题。

- API调用支持:将自然语言指令转化为API调用,以实现与后端服务的互动。

- 文本重写与摘要生成:能够对文本进行重写和摘要,提升信息处理的效率。

- 数学问题解决能力:具备理解和解决数学问题的能力,能够执行相关计算。

MobileLLM的技术原理

- 深而薄的架构设计:采用更多的层数、较少的参数,助力模型学习更高层次的抽象概念。

- SwiGLU激活函数:使用SwiGLU激活函数替代传统的ReLU,以增强模型的非线性表达能力。

- 共享嵌入层:输入和输出的嵌入层共享权重,从而减少参数数量,同时保持或提升性能。

- 优化的注意力机制:通过减少键值头的数量并重复使用,提升注意力机制的效率。

- 块级权重共享:在相邻模型块间共享权重,减少内存层间频繁移动造成的延迟。

- 量化兼容性:支持W8A8的量化技术,使得模型能在资源有限的设备上高效运行,同时保持良好性能。

MobileLLM的项目地址

- GitHub仓库:https://github.com/facebookresearch/MobileLLM

- HuggingFace模型库:https://huggingface.co/collections/facebook/mobilellm-6722be18cb86c20ebe113e95

- arXiv技术论文:https://arxiv.org/pdf/2402.14905

MobileLLM的应用场景

- 移动应用:在移动应用中,MobileLLM能够提供即时的语言理解与生成能力,支持用户与机器人之间的自然对话。

- 语音助手:可集成于智能手机及其他移动设备的语音助手,帮助用户通过自然语言指令完成任务,如设置提醒和搜索信息。

- 内容推荐与过滤:在内容推荐系统中,MobileLLM能够理解用户的兴趣,提供个性化的推荐。

- 教育辅助工具:在教育软件中,MobileLLM作为语言学习助手,帮助用户掌握新语言,提供语法修正和发音指导。

- 移动搜索优化:在移动搜索应用中,MobileLLM提升搜索建议和结果解释的智能化水平,帮助用户迅速找到所需信息。

常见问题

- MobileLLM的主要优势是什么?:MobileLLM在小于十亿参数的情况下,仍然能够提供高质量的语言理解和生成,适合移动设备使用。

- 如何获取MobileLLM?:用户可以通过GitHub或HuggingFace模型库获取MobileLLM的代码和模型。

- MobileLLM支持哪些语言?:MobileLLM支持多种语言,能够进行跨语言的自然语言处理任务。

- 是否可以在资源有限的设备上运行MobileLLM?:是的,MobileLLM支持量化技术,能够在资源受限的设备上高效运行。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号