LayerSkip是一种创新的技术,旨在加速大型语言模型(LLMs)在推理过程中的效率。通过在训练阶段实施层dropout和早期退出损失,LayerSkip使得模型能够在推理时从早期层准确且迅速地退出,从而无需遍历所有层。这种方法显著提高了推理速度,降低了计算资源的消耗,同时保持了较高的准确性。

LayerSkip是什么

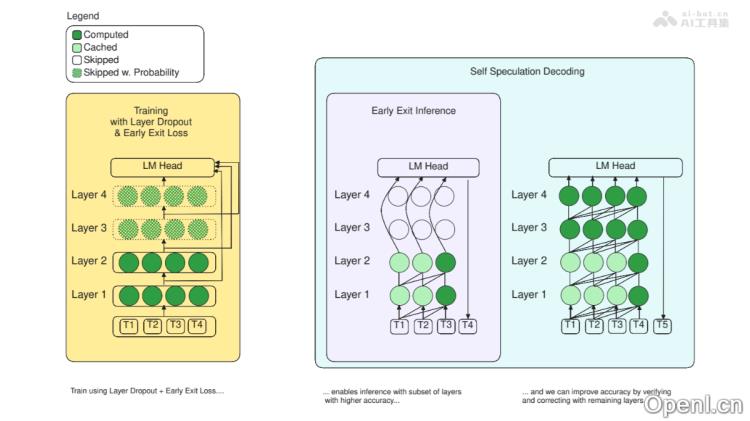

LayerSkip是一种专门用于加速大型语言模型(LLMs)推理过程的技术。它利用在训练阶段引入的层dropout和早期退出损失,帮助模型在推理时能够更有效地从早期层退出,而不必通过所有层。这样一来,不仅提升了模型的推理速度,还显著减少了计算资源的消耗。LayerSkip还引入了一种自我推测解码的方法,该方法基于早期层生成的令牌,以后续层进行验证和修正,从而提高解码效率并减少内存占用。这一技术在文档摘要、编程任务和语析等多种应用中表现出显著的速度提升,同时保持了较高的准确性。

LayerSkip的主要功能

- 加速推理过程:LayerSkip通过减少模型在生成输出时需要遍历的层数,显著提高了推理的速度。

- 精准的早期退出:通过在训练期间应用层dropout和早期退出损失,确保模型在推理时能够从早期层准确退出,不必使用所有层。

- 高效的自我推测解码:LayerSkip创新性地提出了自我推测解码方法,使得模型能够在早期层快速生成预测,并使用剩余层对这些预测进行验证和修正,从而提升了解码效率。

LayerSkip的技术原理

- 层dropout策略:在训练期间,LayerSkip对不同层采用不同的dropout率,早期层的dropout率较低,而后期层的dropout率较高。这种差异化策略促使模型在早期层学习更多普适特征,减少对深层的依赖。

- 早期退出损失机制:为了提高早期层的预测准确性,LayerSkip在训练过程中引入了早期退出损失,使模型的输出层(语言模型头)能够更好地处理来自早期层的嵌入信息。

- 自我推测解码机制:在推理阶段,LayerSkip利用早期层快速生成预测草案,并用模型的剩余层对这些预测进行验证和修正。这种方法基于验证一组令牌比自回归生成每个令牌更为高效的事实,从而显著减少整体推理时间。

- 缓存重用优化:LayerSkip在草案生成和验证阶段重用激活和键值(KV)缓存,进一步降低了内存占用和计算量。

LayerSkip的产品官网

- GitHub仓库:https://github.com/facebookresearch/LayerSkip

- HuggingFace模型库:https://huggingface.co/collections/facebook/layerskip-666b25c50c8ae90e1965727a

- arXiv技术论文:https://arxiv.org/pdf/2404.16710

LayerSkip的应用场景

- 实时应用场景:在需要即时反馈的环境中,如在线客服、机器人和语音识别系统,LayerSkip能够显著提升响应速度,改善用户体验。

- 移动与边缘计算:LayerSkip减少了模型的计算需求,使大型语言模型能够在资源受限的移动设备或边缘设备上运行,适合离线或低延迟的应用需求。

- 在线翻译服务:在多语言环境下,LayerSkip加速语言模型的推理过程,提供更加迅速的翻译服务。

- 内容生成应用:在生成文章、报告或代码等文本内容的场景中,LayerSkip能够加快内容生成速度,缩短创作时间。

- 自然语言处理(NLP)任务:LayerSkip广泛运用于文本摘要、情感分析、问答系统等各种NLP任务,提高处理速度。

常见问题

- LayerSkip适合哪些类型的模型?:LayerSkip设计用于各种大型语言模型,特别是那些需要高效推理的应用场景。

- 使用LayerSkip会影响模型的准确性吗?:LayerSkip通过优化推理过程,保持了较高的准确性,通常不会影响模型的性能。

- 如何在项目中集成LayerSkip?:可以通过访问LayerSkip的GitHub仓库获取详细的集成指南和示例代码。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号