AMD-135M是什么

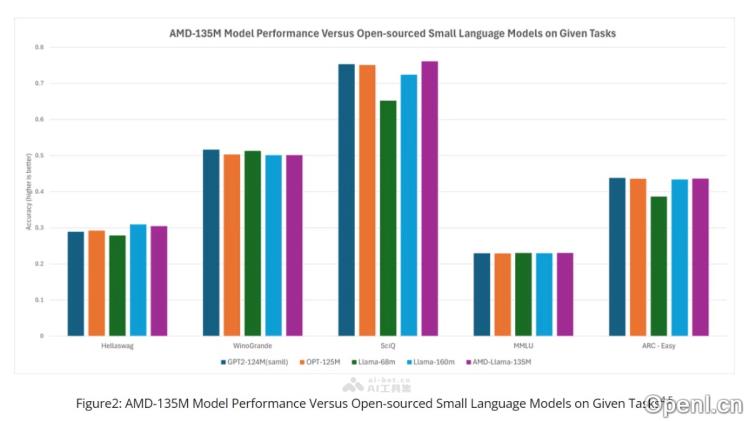

AMD-135M是AMD公司推出的首款小型语言模型(SLM),旨在为特定应用场景提供性能与资源消耗的最佳平衡。该模型基于LLaMA2架构,并使用AMD Instinct MI250加速器进行训练,训练数据量达到670亿个token。AMD-135M有两个版本可供选择:通用文本处理的AMD-Llama-135M和专注于编程的AMD-Llama-135M-code。通过推测解码技术,AMD-135M能够在每次前向推理中生成多个token,从而显著提升推理速度并减少内存占用。在性能方面,AMD-135M在多种自然语言处理任务上的表现与其他同类模型相当,例如,在Humaneval数据集上使用MI250 GPU时,模型的通过率大约为32.31%,展现出卓越的性能。

AMD-135M的主要功能

- 文本生成:能够生成连贯且自然的文本,适用于机器人、内容创作等多种应用。

- 代码生成:基于经过微调的AMD-Llama-135M-code版本,支持代码生成和编程辅助。

- 自然语言理解:具备理解输入文本意图和上下文的能力,适合问答系统和摘要生成等任务。

- 多平台兼容性:可在多种硬件平台上运行,包括AMD的GPU和CPU。

AMD-135M的技术原理

- 推测解码:通过小型草稿模型生成候选token,再由大型目标模型进行验证,从而提高推理效率。

- 自回归方法:采用传统生成方法,每次前向传递生成一个token,但经过推测解码技术的优化。

- 多头注意力机制:利用多头注意力机制增强模型对文本中不同部分之间关系的理解能力。

- 位置编码:采用相对位置编码(RoPE),保持序列中单词的顺序信息。

- 激活函数:使用专为语言模型设计的Swiglu激活函数。

- Layer Norm:应用RMSNorm(均方根归一化)来稳定训练过程。

- 模型架构:基于LLaMA-2模型架构,具备12层和768个隐藏单元等技术规格。

AMD-135M的项目地址

- 项目官网:amd-first-slm-135m-model-fuels-ai-advancements

- HuggingFace模型库:https://huggingface.co/amd/AMD-Llama-135m

AMD-135M的应用场景

- 机器人:作为机器人的核心,提供自然语言的理解与生成能力,实现与用户之间的互动对话。

- 内容创作:辅助撰写,生成文章、故事或其他文本内容的初稿。

- 编程辅助:利用AMD-Llama-135M-code版本,帮助开发者生成代码片段,提供编程建议与自动补全功能。

- 语言翻译:尽管模型主要针对英语,但其架构也能适应其他语言,适用于机器翻译任务。

- 文本摘要:自动生成文本的摘要,便于快速了解新闻、文章或报告的核心内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号