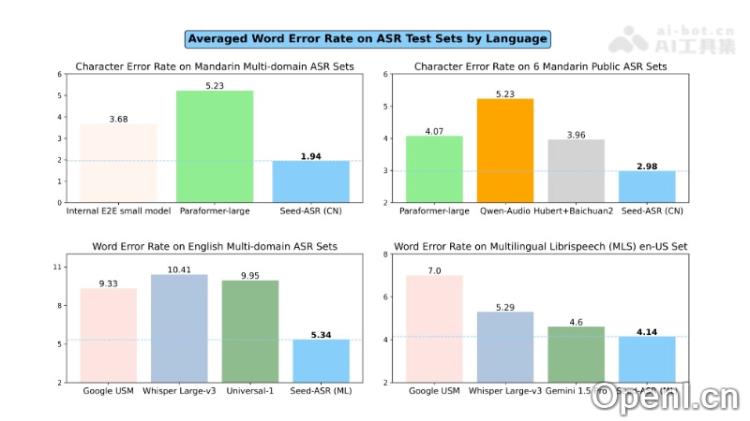

Seed-ASR是一款由字节跳动开发的高性能语音识别模型,基于大型语言模型(LLM)构建。该模型经过超过2000万小时的语音数据和近90万小时的配对ASR数据的训练,能够支持普通话及13种中国方言的转录,同时也能识别英语和其他7种外语。Seed-ASR的创新技术使其在背景噪音和多人交谈的复杂环境中,识别准确率比现有大型ASR模型低10%-40%。以下是Seed-ASR的详细介绍。

Seed-ASR是什么

Seed-ASR是字节跳动推出的一款先进的语音识别(ASR)模型,利用强大的大型语言模型(LLM)来进行语音到文本的转换。它经过大规模的语音数据训练,能够高效支持多种语言和方言的转录,并在上下文理解方面表现出色。这款模型在众多应用场景中表现出色,包括视频转录、在线会议和实时直播等,能够在嘈杂环境中依然保持高识别准确率。

Seed-ASR的主要功能

- 高精度语音识别:能够精准识别和转录多种语言、方言与口音的语音信号。

- 多语言支持:不仅支持普通话和英语,还具备扩展至超过40种语言的潜力。

- 上下文感知:通过历史对话和其他上下文信息提升关键词的识别和转录准确性。

- 大规模训练:利用丰富的语音数据训练,增强模型的泛化能力和适应性。

- 分阶段训练策略:采用自监督学习、监督微调、上下文微调和强化学习等多种阶段性训练,逐步提升模型性能。

- 长语音处理:有效处理长时间的语音输入,确保信息完整性与转录准确性。

Seed-ASR的技术原理

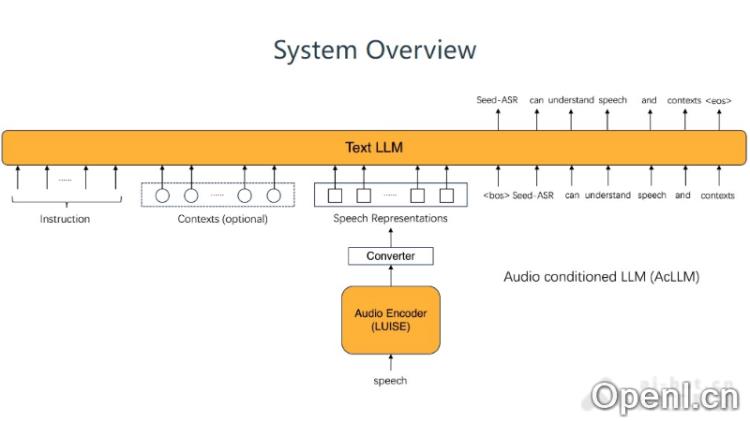

- 大型语言模型(LLM)基础:Seed-ASR建立在强大的大型语言模型上,具备卓越的文本理解和生成能力。

- 音频条件的语言模型(AcLLM)框架:该框架通过输入连续的语音信号与上下文信息,利用预训练的LLM生成相应文本。

- 自监督学习(SSL):通过大规模无标签的语音数据训练,捕捉丰富的语音特征。

- 监督微调(SFT):在自监督学习后,使用大量语音-文本对进行训练,建立语音到文本的映射关系。

- 上下文感知训练:引入上下文信息(如历史对话)来提升模型在特定场景下的识别能力。

- 强化学习(RL):基于ASR性能指标优化模型的文本生成,特别关注语义重要部分的准确转录。

Seed-ASR的项目地址

- 项目官网:https://bytedancespeech.github.io/seedasr_tech_report/

- arXiv技术论文:https://arxiv.org/pdf/2407.04675

如何使用Seed-ASR

- 环境准备:确保拥有满足Seed-ASR运行需求的硬件和软件条件,包括足够的计算能力、内存和存储空间。

- 获取模型:授权用户可通过字节跳动或相关渠道获取Seed-ASR模型及其必要的依赖库。

- 数据准备:收集并准备待处理的语音数据,包括音频文件或实时语音流。

- 数据预处理:对语音数据进行必要的预处理,如去噪、分割和归一化,以提高识别精度。

- 模型配置:根据应用场景配置Seed-ASR模型参数,包括选择语言和输入上下文信息。

- 模型部署:将Seed-ASR模型部署到服务器或云平台上,确保能够处理语音数据。

Seed-ASR的应用场景

- 智能助手和语音交互:在智能手机、家居设备等中实现语音指令识别和互动功能。

- 自动字幕生成:为视频内容、直播和会议等自动生成字幕,提升内容的可获取性。

- 会议记录和转录:在商务会议、讲座和研讨会中自动记录并转录语音为文本。

- 客户服务:在呼叫中心或在线客服中自动理解客户的语音,提高响应速度与问题解决效率。

- 语音搜索:在搜索引擎或应用中支持语音输入,帮助用户快速找到所需信息。

- 语言学习和教育:为语言学习者提供发音和听力练习的实时反馈及改进建议。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号