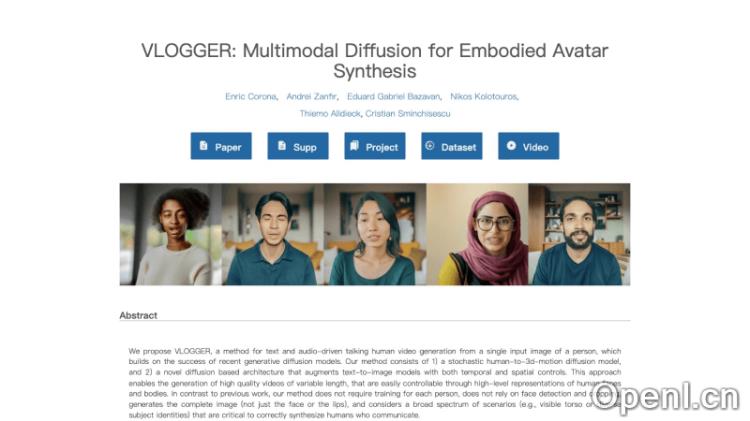

VLOGGER是一款由谷歌研究团队开发的多模态扩散模型,旨在从单一图像和音频样本生成真实而连贯的人像动态视频。它的核心功能在于通过人工智能技术,将静态图片转化为动态视频角色,同时保持角色的逼真外观。此外,VLOGGER能够根据音频控制角色的动作,包括面部表情、嘴唇同步、头部、目光、眨眼以及身体和手部的手势,从而将视频合成的效果提升到新的高度。

VLOGGER是什么

VLOGGER是一个由谷歌研究团队开发的多模态扩散模型,专门从单一输入图像和音频样本生成逼真的人像动态视频。该模型的主要特性在于利用人工智能技术,将一张静态图片变成一个动态视频角色,并保持人物的真实外观。同时,VLOGGER能够根据音频的内容来控制角色的动作,不仅限于面部表情和嘴唇的同步,还涵盖头部、目光、眨眼以及上身和手部的手势,极大地提升了音频驱动的视频合成效果。

VLOGGER的官网入口

VLOGGER的主要功能

- 基于图像和音频生成视频:用户只需提供一张人物图像和一段音频,VLOGGER便能生成一个视频中的角色,其面部表情、嘴唇动作与音频内容完美同步,展现出自然流畅的动态效果。

- 丰富的多样性和真实感:VLOGGER生成的视频展现出高度的多样性,能展示原始人物的不同动作和表情,同时保持背景的一致性和视频的真实感。

- 视频编辑功能:VLOGGER还可以用于现有视频的编辑,比如改变视频中角色的表情,使其与原始视频的未改变像素保持一致。

- 生成会说话的动态角色:即便没有视频中人物的原始素材,VLOGGER也能从一张输入图像和音频生成逼真的说话视频。

- 视频翻译能力:VLOGGER能够将一种语言的视频转换为另一种语言,通过编辑唇部和面部区域以匹配新的音频,实现跨语言的视频内容适配。

VLOGGER的工作原理

VLOGGER的工作流程主要分为两个阶段,结合了音频驱动的生成和时间连贯的视频生成。

第一阶段:音频驱动的生成

- 音频处理:VLOGGER首先接收一段音频输入,可能是语音或音乐。如果输入是文本,系统会通过文本到语音(TTS)模型将其转换为音频波形。

- 3D预测:接下来,系统使用基于变换器(Transformer)架构的网络处理音频输入。该网络经过训练,能够预测与音频同步的3D面部表情和身体姿势,并利用多步注意力层捕捉音频的时间特征,生成一系列3D姿势参数。

- 生成控制表示:网络输出一系列预测的面部表情(θe i)和身体姿势的残差(∆θb i),这些参数用于生成控制视频生成过程的2D表示。

第二阶段:时间连贯的视频生成

- 视频生成模型:VLOGGER的第二个阶段是一个时间扩散模型,它接收第一阶段生成的3D控制和一张参考图像(即输入的单一人物图像)。

- 条件化视频生成:视频生成模型是一个基于扩散的图像到图像翻译模型,利用预测的2D控制生成一系列帧,依据输入的音频和3D参数进行动画处理。

- 超分辨率提升:为了提高视频质量,VLOGGER还包括一个超分辨率扩散模型,将基础视频的分辨率从128×128提升到更高的分辨率,如256×256或512×512。

- 时间延展技术:VLOGGER采用时间延展(temporal outpainting)技术生成任意长度的视频,首先生成一定数量的帧,然后基于前一帧的信息迭代生成新的帧,从而扩展视频的长度。

数据集和训练过程

- VLOGGER在一个名为MENTOR的大规模数据集上进行训练,该数据集包含2200个小时和800000个身份,涵盖了大量身份和动态手势。训练过程中,模型学习如何根据3D姿势参数和输入图像生成连贯的、高质量的视频序列。

应用场景

VLOGGER可以广泛应用于社交媒体内容创作、在线教育、虚拟会议、游戏开发以及影视制作等领域,为用户提供更加生动和有趣的视觉体验。

常见问题

Q1: VLOGGER支持哪些输入格式?

A1: VLOGGER支持单张静态图像和音频文件作为输入,音频可以是语音或音乐。

Q2: 生成的视频质量如何?

A2: VLOGGER生成的视频具有高真实感和多样性,能够展示丰富的表情和动作。

Q3: VLOGGER是否可以用于视频编辑?

A3: 是的,VLOGGER可以用于编辑现有视频,改变角色的表情等。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号