来吧,说透layernorm。

原标题:希望这篇是最清晰好懂的 Layernorm 原理解析

文章来源:JioNLP

内容字数:8415字

1. 引言

大家好,我是 JioNLP。本文主要讨论 Layer Normalization(层归一化),简称 layernorm。它是一种数据分布归一化方法,在神经网络训练中具有重要作用,能够提升训练效率并解决 Internal Covariate Shift 问题。

2. Layernorm 的应用场景

Layernorm 主要应用于自然语言处理领域,尤其是在基于 token 的神经网络模型中,如 Bert 和 GPT。每个 token 对应一个 embedding 向量,这些向量之间的关系通常使用余弦相似度来表示。

3. Layernorm 的符号解释

在 layernorm 中,通常涉及三个维度:B(Batch)、T(Time/Token)和 D(Hidden Dimension)。layernorm 操作仅作用于 D 维度,即每个 token 内部向量的各个维度。

4. Layernorm 的前向计算过程

首先计算每个 token 向量的均值和方差,然后将其归一化到标准正态分布。接着,通过引入参数进行线性变换,确保数据的相似度尽量保持一致。

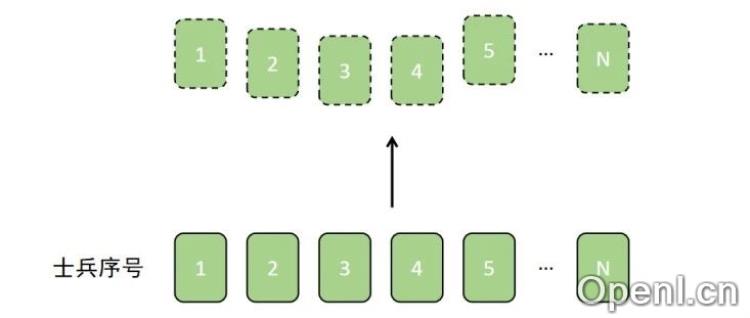

5. Layernorm 的本质

Layernorm 的本质是将每个 batch 中的所有 token 的分布归一化到同一水平,类似于军队训练时的队列整齐化过程。其核心思想是对 token 进行归一化处理,以保持一致性。

6. Layernorm 的反向传播过程

反向传播过程包括计算梯度,涉及输入、输出及参数的梯度。通过复合函数求导,计算均值和标准差对输入的梯度,从而完成参数更新。

7. 代码示例

本文附上了来自大神 Karpathy 的 LayerNorm 实现代码,展示了其前向和反向计算的具体实现,便于读者理解 layernorm 的具体操作。

8. 结论

通过对 layernorm 的深入分析,我们可以看到它在自然语言处理中的重要性,以及如何通过归一化处理提升神经网络的性能。希望本文能够帮助读者更好地理解 layernorm 的原理和应用。

联系作者

文章来源:JioNLP

作者微信:

作者简介:用数学和程序解构世界。

粤公网安备 44011502001135号

粤公网安备 44011502001135号