LongRAG是一款由清华大学、中国科学院及智谱研究团队共同开发的双视角鲁棒检索增强生成(RAG)框架,专注于长文本问答(LCQA)。该系统通过结合混合检索器、LLM增强信息提取器、CoT引导过滤器和LLM增强生成器四大核心组件,有效应对长文本问答中的全局上下文理解和细节识别的挑战。LongRAG在多个数据集上优于长上下文LLM、高级RAG系统及普通RAG等基准模型,展现出其卓越的性能和鲁棒性。此外,LongRAG还提供了自动化微调数据构建管道,提升系统的“指令跟随”能力和领域适应性。

LongRAG是什么

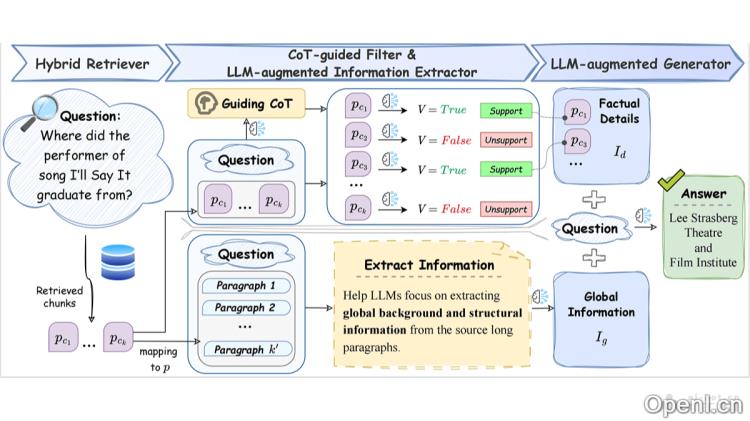

LongRAG是清华大学、中国科学院与智谱研究团队推出的一种面向长文本问答(LCQA)的双视角鲁棒检索增强生成框架。系统基于混合检索器、LLM增强信息提取器、CoT引导过滤器以及LLM增强生成器四个主要组件,旨在有效解决长文本问答中的全局上下文理解与事实细节识别问题。在多个数据集上,LongRAG的表现超越了长上下文LLM、高级RAG系统及传统RAG模型,显示出其卓越的性能和稳定性。它还提供了自动化微调数据构建流程,增强了系统在特定任务上的表现。

LongRAG的主要功能

- 双视角信息处理:通过整合全局信息和事实细节,提升对长文本上下文问题的理解与回答能力。

- 混合检索器:快速从海量数据中检索与用户问题相关的信息片段。

- LLM增强信息提取器:将检索到的片段映射回原始的长文本段落,提取出全局背景及结构信息。

- CoT引导过滤器:利用链式思考(Chain of Thought,CoT)引导模型关注与问题相关的信息,过滤掉无关内容。

- LLM增强生成器:结合全局信息和关键事实细节生成最终答案。

- 自动化微调数据构建:基于自动化流程生成高质量微调数据集,提高模型在特定任务上的表现。

LongRAG的技术原理

- 检索增强生成(RAG):基于RAG框架,利用外部知识辅助语言模型生成回答。

- 全局信息和细节信息的整合:系统不仅关注局部事实细节,还整合长文本中的全局信息,以提供更全面的答案。

- 映射策略:将检索到的片段映射回原始的长文本,恢复上下文信息,从而提供更为准确的背景结构。

- 链式思考(CoT):利用CoT作为全局线索,指导模型逐步关注与问题相关的知识,提升证据密度。

- 过滤策略:基于CoT的全局线索,过滤掉不相关的信息片段,保留关键事实细节。

LongRAG的项目地址

- GitHub仓库:https://github.com/QingFei1/LongRAG

- arXiv技术论文:https://arxiv.org/pdf/2410.18050

LongRAG的应用场景

- 客户服务与支持:在客户服务领域,能够有效理解并回答长篇客户查询或历史交互记录,提供更准确的解决方案。

- 医疗咨询:在医疗行业内处理大量患者记录和医学文献,回答医生或患者关于疾病、治疗及药物的复杂问题。

- 法律咨询:帮助法律专业人士分析大量法律文件和案例,提供关于法律问题的深入分析与建议。

- 教育与研究:在教育领域,作为辅助工具,帮助学生和研究人员深入理解长篇学术文章和研究报告,解答相关问题。

- 企业决策支持:分析市场研究报告、企业年报等长篇文档,为商业决策提供数据支持和洞察。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号