Mooncake是一款由月之暗面Kimi与清华大学等机构联合开发并开源的大规模模型推理架构。该架构采用以KVCache为核心的分布式设计,通过的预填充和解码集群,充分挖掘GPU集群中未被充分利用的CPU、DRAM及SSD资源,显著提升大模型推理的吞吐量并降低计算成本。Mooncake在确保服务延迟相关的服务级别目标(SLO)之下,能够高效处理高负载场景。

Mooncake是什么

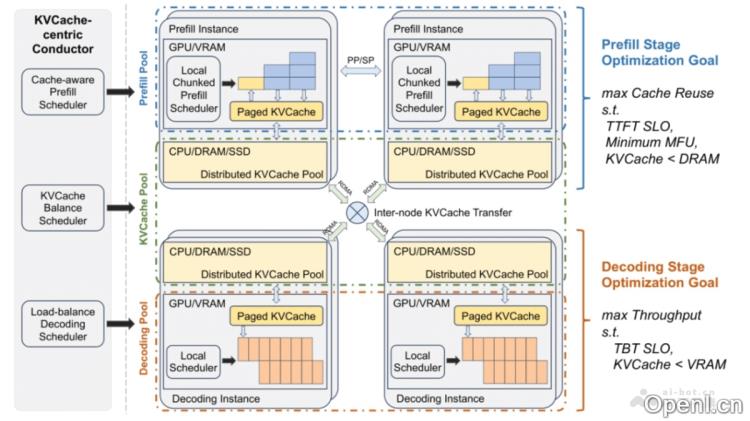

Mooncake是一种旨在优化大模型推理的开源架构,由Kimi与清华大学等多家机构共同开发。其核心基于KVCache的分布式架构,通过将预填充与解码过程分开,充分利用GPU集群中的CPU、DRAM和SSD等资源,实现高效的缓存管理。Mooncake的最大优势在于能够在处理长上下文时显著提高推理吞吐量,同时降低算力开销,使其在高负载情况下依然能够保持良好的响应时间。该项目已在Github上开源,推动了大模型技术的高效推理平台的进展。

Mooncake的主要功能

- 高效的大模型推理:Mooncake通过其独特的分布式架构,优化了大模型的推理过程,尤其在处理长上下文数据时,能够显著提高推理的吞吐量。

- KVCache中心化设计:以KVCache为核心,Mooncake实现了高效的数据缓存与重用,降低了对GPU资源的依赖,减少了计算成本。

- 预填充与解码分离:该架构将预填充和解码两个阶段分开处理,能够针对不同计算特性进行优化。

- 资源优化:通过分离设计,Mooncake能够更有效地利用CPU、DRAM和SSD资源,提升整体资源利用率。

- 负载均衡:Mooncake实现了基于缓存负载的均衡策略,通过自动热点迁移提升了缓存命中率和系统的负载均衡。

- 过载管理:在高负载情况下,Mooncake采用基于预测的早期拒绝策略,优化资源分配,降低无效计算。

- 高性能传输:基于RDMA技术,Mooncake实现了跨节点的高速KVCache传输,显著降低了延迟。

- 标准化接口:Mooncake为大模型时代建立了新型高性能内存语义存储的标准接口,提供了参考实现方案。

- 成本降低:通过优化推理过程和提高资源利用效率,Mooncake帮助降低大模型推理的整体成本,使AI技术更加经济高效。

Mooncake的技术原理

- 分布式架构:充分利用GPU集群中的CPU、DRAM和SSD资源,Mooncake实现了KVCache的分布式存储与传输,提高了缓存容量和传输带宽,降低了对单一GPU的依赖。

- 全局调度器(Conductor):负责根据当前KVCache的分布状态和工作负载情况来调度请求,并决定KVCache块的复制或交换,以优化整体吞吐量并满足服务级别目标(SLO)。

- 分块流水线并行(Chunked Pipeline Parallelism):在处理长上下文请求时,将输入标记分为多个块,并在不同节点上并行处理,以降低延迟。

- Layer-wise预填充:通过异步加载和存储KVCache,重叠传输与计算,减少VRAM占用。

- 缓存感知调度:Mooncake的调度算法充分考虑KVCache的重用、预填充时间与实例负载的排队时间,以实现高效的请求调度。

Mooncake的项目地址

- Github仓库:https://github.com/kvcache-ai/Mooncake

- arXiv技术论文:https://arxiv.org/pdf/2407.00079

Mooncake的应用场景

- 自然语言处理(NLP):Mooncake可支持多种NLP任务,包括语言翻译、文本摘要、情感分析、问答系统及机器人等。

- 内容推荐系统:在推荐系统中,Mooncake可以处理用户行为数据与内容特征,以提供个性化推荐。

- 搜索引擎:Mooncake能够改善搜索引擎的查询理解和文档排名,通过解析复杂的查询意图和文档内容,提供更准确的搜索结果。

- 语音识别与生成:在语音识别领域,Mooncake可提高语音转文本的准确性;在语音生成领域,则能生成更自然流畅的语音输出。

- 图像和视频分析:其高效的推理能力也可辅助图像和视频分析任务,如图像标注和视频内容理解等。

- 智能客服与虚拟助手:Mooncake为智能客服和虚拟助手提供强大的后端支持,使其能够处理复杂对话和任务。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号