研究团队针对剪枝多模态大模型以实现高效计算的挑战进行了研究。

原标题:12%计算量就能媲美原模型,Adobe、罗切斯特大学等提出YOPO剪枝技术

文章来源:机器之心

内容字数:5574字

研究背景

近年来,多模态大模型的能力随着模型规模和输入图像分辨率的增加而显著提升。然而,随之而来的计算开销也大幅增加,限制了其在实际应用中的可扩展性。近年来的研究表明,视觉 token 的数量通常显著多于文本 token,这种不平衡造成了计算成本的急剧上升。为了解决这一问题,研究团队提出了一系列剪枝方案,以减少模型的计算冗余。

YOPO剪枝方案

本研究的核心是提出了一种名为 YOPO(You Only Prune Once)的剪枝方案,旨在在不增加额外计算量的前提下,有效减少多模态大模型的计算冗余。实验结果显示,LLaVA-1.5 模型在保留仅12%计算量的情况下,仍能达到与原始模型相同的性能。

主要方法

研究团队提出了以下几种剪枝策略:

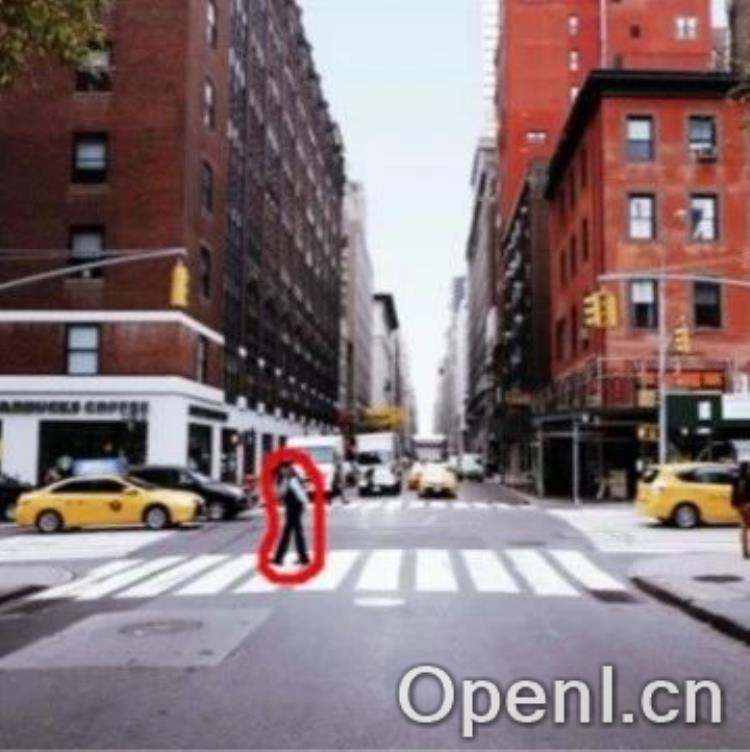

- 邻域感知视觉注意力:通过选择性消除视觉 token 之间不必要的注意力计算,减少计算复杂度。

- 非活跃注意力头剪枝:发现大约一半的注意力头未被激活,提出对其进行剪枝以消除冗余计算。

- 选择性层丢弃:通过分析不同层的注意力权重,跳过后面的层中与视觉相关的计算。

- FFN中的稀疏视觉投影:在每个 transformer 模块内随机丢弃一定比例的神经元,以有效利用视觉表示的稀疏性。

实验结果

在多个基准测试上,提出的方法均取得了最佳结果,相比于其他剪枝方法,性能下降幅度更小。尤其是在大规模基准测试 VQAv2 和 GQA 上,采用 YOPO 方法的模型在减少计算量的同时,依然保持了良好的性能。

总结与展望

本研究通过分析多模态大模型中的冗余性,提出了一系列高效的剪枝策略,显著降低了计算开销,提升了模型的应用潜力。未来,研究团队将继续探索其他模型中的冗余,并进一步优化剪枝技术,以实现更高效的多模态学习。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号