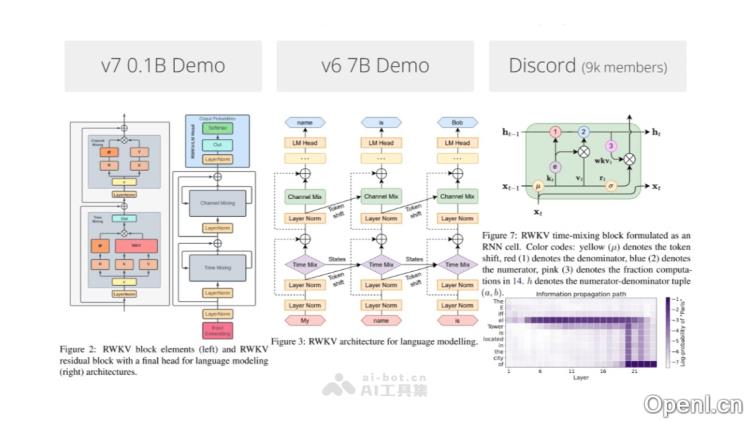

RWKV-7是RWKV系列最新的大型模型架构,超越了传统的注意力机制和线性注意力范式,展现出更灵活的状态演化能力,使其能够在相同的计算资源下解决以往注意力机制无法解决的问题。RWKV-7的研究始于2024年9月,首个预览版本RWKV-7 "Goose" x070.rc2-2409-2r7a-b0b4a的训练代码已在RWKV-LM仓库发布。该架构的核心优势在于其强大的上下文学习能力和训练过程的稳定性与效率。RWKV-7确认采用“rc4a”版本作为最终代码,并已推出0.1B和0.4B两种参数模型。RWKV-7的研究与开发仍在持续推进,不断有新进展和新模型发布。

RWKV-7是什么

RWKV-7是RWKV系列的最新大模型架构,打破了传统注意力和线性注意力的限制,具备灵活的状态演变能力,能够在相同算力下解决以往注意力机制无法处理的问题。RWKV-7的研发始于2024年9月,首次发布的预览版训练代码在RWKV-LM仓库中提交,其核心优势在于卓越的上下文学习(ICL)能力,以及在训练过程中的稳定性和高效性。目前,RWKV-7已确认使用“rc4a”版本,发布了0.1B和0.4B两种参数模型,研究和开发仍在不断推进。

RWKV-7的主要功能

- 超越传统注意力机制:RWKV-7架构突破了传统的注意力和线性注意力范式,具备更为灵活的状态演化能力,能够在相同计算资源下解决传统注意力无法应对的问题。

- 动态学习策略:RWKV-7利用加权关键值(WKV)机制,能够高效处理信息,灵活调整学习策略以适应变化。

- 动态状态更新:该模型的动态状态更新公式允许在每个时间步保留重要信息,同时灵活应对新的输入。

- 动态学习率调整:RWKV-7通过特定公式实现学习率的动态调整,使得学习过程更加稳定。

- 上下文学习率:引入“上下文学习率”概念,使模型能够在不同上下文中自适应调整学习率,提升在变化环境中的灵活性和学习效率。

- 高效推理和低显存占用:RWKV-7能够处理无限上下文,特别适合长文本处理和多轮对话,且对硬件友好,仅需执行矩阵与向量的乘法,无需KV缓存。

- 递归网络推理:RWKV-7基于递归神经网络结构,推理阶段可方便地采用递归方式解码。

- 额外优化方案:RWKV-7采用小初始化嵌入和自定义初始化等优化策略,加速并稳定训练过程,同时在更深层架构中实现更优的收敛性。

RWKV-7的产品官网

RWKV-7的应用场景

- 文本生成:RWKV-7能够生成流畅、连贯的文本,适合小说、诗歌等创意写作任务。

- 机器翻译:RWKV-7处理长句和复杂语法结构,提升翻译的准确性与流畅性。

- 情感分析:RWKV-7能够深入理解文本情感,为电商和社交领域提供精准的情感分析服务。

- 对话系统:RWKV-7具备长期上下文记忆能力,为对话系统提供更自然、连贯的交互体验。

- 多语言处理:在多语言任务中,RWKV-7表现优异,尤其在中文和日文等非英语语言上效果显著。

- 代码生成:RWKV-7在程序代码生成方面表现良好,能够辅助编程工作。

常见问题

- RWKV-7与之前的版本有何不同? RWKV-7在架构设计上超越了传统注意力机制,具备更灵活的状态演化能力,提升了学习效率和稳定性。

- RWKV-7适合哪些应用场景? RWKV-7广泛适用于文本生成、机器翻译、情感分析、对话系统等多种应用场景。

- 如何获取RWKV-7模型? 用户可以访问RWKV的官方网站或Github仓库下载相关模型和代码。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号