Emotion-LLaMA – 多模态情绪识别与推理模型,融合音频、视觉和文本输入

Emotion-LLaMA是什么

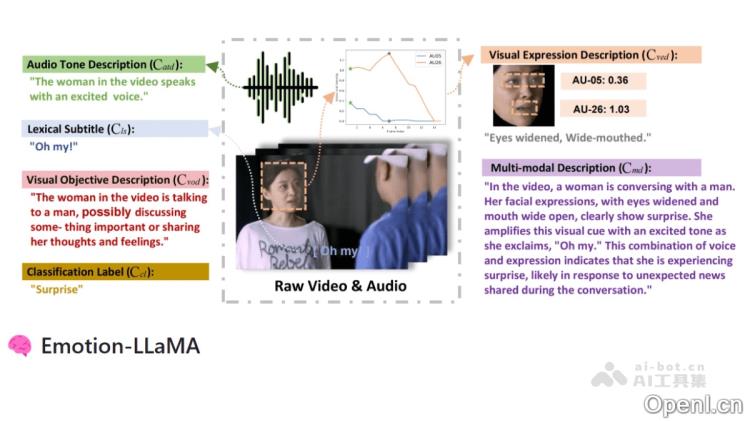

Emotion-LLaMA是一款先进的多模态情绪识别与推理模型,能够融合音频、视觉和文本输入,利用专门的情绪编码器整合信息。该模型基于经过改进的LLaMA架构,并通过指令微调来增强其情感识别能力。研究团队构建了MERR数据集,以支持模型的训练与评估,使得Emotion-LLaMA能够从多样化场景中学习并应用于现实世界。在多个数据集和竞赛中,Emotion-LLaMA展现出了卓越的表现,例如在MER2024挑战赛的MER-NOISE赛道中以84.52%的加权准确率超越其他参赛团队。其架构设计巧妙,充分挖掘了LLaMA的潜力,纳入了关键的情感线索。

Emotion-LLaMA的主要功能

- 多模态情绪识别:该模型通过情绪专用编码器,无缝整合音频、视觉和文本输入,能够更精确地识别复杂的情绪表达。它可以处理包含人物面部表情、肢体语言和上下文信息的图像或视频,预测最可能的情绪类别,并显示相应的置信度分数。

- 情绪推理:在处理多模态输入(如包含音频和文本的视频片段)时,Emotion-LLaMA能够生成自然语言的解释,分析数据中的面部表情、声音特征和语言内容,从而生成连贯且类似人类的解释,强调对情绪预测起重要作用的线索和模式,为需要透明和可解释的情绪理解的应用提供了重要价值。

- 数据集构建与训练支持:研究团队建立了MERR数据集,包括28618个粗粒度和4487个细粒度标注样本,涵盖多种情绪类别,使模型能够从多种场景中学习并推广至实际应用,成为大规模多模态情绪模型训练与评估的宝贵资源。

- 卓越的性能表现:在多个数据集和竞赛中,Emotion-LLaMA的表现均十分出色,例如在EMER数据集上,模型在线索重叠和标签重叠得分中名列前茅,在MER2023-SEMI挑战赛中F1分数达0.9036,在MER2024-NOISE挑战赛中F1分数为0.8452,同时在DFEW数据集的零样本评估中超越了ChatGPT-4V。

Emotion-LLaMA的技术原理

- 多模态输入融合:Emotion-LLaMA通过情绪专用编码器,能够高效整合音频、视觉和文本输入。模型采用HuBERT作为音频编码器,以及多视图视觉编码器(如MAE、VideoMAE、EVA),以捕捉面部细节和动态上下文,从而更全面地理解情绪表达。

- 特征对齐与指令微调:该模型将来自不同模态的特征对齐到共享空间,采用经过指令微调的LLaMA模型,从而增强其对情绪相关任务的理解和处理能力,提升情感识别和推理效果。

- 数据集构建:为支持模型的训练与评估,研究者建立了MERR数据集,包含28618个粗粒度和4487个细粒度标注样本,涵盖多种情绪类别,帮助模型从不同场景中学习并推广至现实应用。

- 基于Transformer架构:Emotion-LLaMA的核心架构基于Transformer,采用自回归生成机制、多头自注意力机制、前馈神经网络(FFN)、残差连接和位置编码等技术,以实现高效的自然语言生成和情绪推理。

Emotion-LLaMA的产品官网

- Github仓库:https://github.com/ZebangCheng/Emotion-LLaMA

- arXiv技术论文:https://arxiv.org/pdf/2406.11161

- 在线体验Demo:https://huggingface.co/spaces/ZebangCheng/Emotion-LLaMA

Emotion-LLaMA的应用场景

- 人机交互:在智能助手和机器人等应用中,Emotion-LLaMA可以实时分析用户的情绪状态,生成基于情感的个性化回复,从而改善用户体验,使机器更好地理解和回应人类的情感需求。

- 教育领域:教师可利用Emotion-LLaMA了解学生的情感状态,从而提供更具针对性的教学支持。

- 心理健康支持:在心理健康咨询与干预中,该模型能够识别用户的情感状态,为心理咨询师提供更准确的情绪分析,从而提供及时的心理干预和支持,辅助治疗过程。

- 客户服务:企业可以将Emotion-LLaMA应用于客服系统,通过分析客户的情绪状态,为其提供更个性化和周到的服务。

- 社交媒体分析:通过对社交媒体评论和帖子进行情感分析,可以洞察用户的情绪趋势,为企业提供有价值的市场洞察。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号