Prometheus:一种3D感知的隐空间扩散模型。

原标题:几秒生成逼真3D场景!浙大&蚂蚁等提出Prometheus,泛化媲美Stable Diffusion

文章来源:智猩猩GenAI

内容字数:13193字

Prometheus: 高效的文本到3D场景生成模型

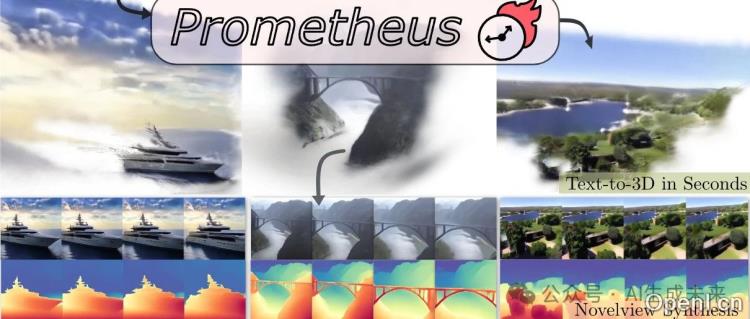

本文介绍了Prometheus,一个面向文本到3D生成的3D感知隐空间扩散模型,能够高效生成对象级别和场景级别的3D内容。Prometheus采用两阶段训练框架,并结合了多视角信息和RGB-D数据,在保真度、几何质量和泛化能力方面取得了显著进展。

1. 核心创新

Prometheus的主要创新在于其独特的两阶段训练框架和对RGB-D隐空间的利用。第一阶段训练一个3D高斯变分自编码器(GS-VAE),将多视角或单视角RGB-D图像编码为像素对齐的3D高斯表示。第二阶段训练一个多视角隐空间扩散模型(MV-LDM),以文本提示和相机姿态为条件,在GS-VAE生成的隐空间中进行生成。这种方法有效地解耦了外观和几何信息,提高了生成效率和质量。

2. 两阶段训练框架

第一阶段 (GS-VAE): GS-VAE利用预训练的图像编码器(例如Stable Diffusion编码器)对多视角RGB-D图像进行编码,并通过多视图Transformer融合多视角信息和相机姿态。解码器则将融合后的隐空间表示解码为像素对齐的3D高斯场景。损失函数包含重建损失(MSE和感知损失)和深度损失,以确保重建图像和几何信息的准确性。

第二阶段 (MV-LDM): MV-LDM基于一个预训练的文本到图像扩散模型(例如Stable Diffusion的UNet),在GS-VAE生成的隐空间中进行训练。它以文本提示和相机姿态为条件,通过迭代去噪过程生成多视角RGB-D隐空间编码,最终解码为3D高斯场景。为了平衡多视图一致性和保真度,采用混合采样引导和CFG重标定策略。

3. 数据集和实验结果

Prometheus在9个多视角和单视角数据集的组合上进行训练,包括物体中心、室内、室外和驾驶场景等。实验结果表明,Prometheus在3D重建和文本到3D生成任务中均取得了优异的性能,其生成速度快(几秒钟内完成),生成的3D内容保真度高,几何质量好,并且具有良好的泛化能力,与Stable Diffusion的泛化能力相当。

与基线方法相比,Prometheus在3D重建方面,尤其是在视图重叠较少的困难场景中,表现出显著的优势。在文本到3D生成方面,Prometheus生成的3D场景包含丰富的细节,优于基于优化和前馈的基线方法。

4. 消融实验

消融实验验证了RGB-D隐空间、大规模数据集、高噪声水平以及混合采样和CFG重标定策略对模型性能的贡献。结果表明,这些设计选择对于实现高质量和高效的文本到3D生成至关重要。

5. 结论

Prometheus是一个高效且高质量的文本到3D场景生成模型,其两阶段训练框架和对RGB-D隐空间的利用,为文本到3D生成领域带来了显著的提升。该模型在速度、保真度、几何质量和泛化能力方面均表现出色,为未来的3D内容生成研究提供了新的方向。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下公众号之一,专注于生成式人工智能。

粤公网安备 44011502001135号

粤公网安备 44011502001135号