能够在快速实现训练和压缩的同时,得到精准的几何结构与逼真的实时渲染体验。

原标题:ICLR 2025|高效重建几何精准的大规模复杂三维场景,中科院提出CityGaussianV2

文章来源:机器之心

内容字数:6578字

高效精准重建大规模复杂场景:CityGaussianV2算法详解

机器之心AIxiv专栏报道了中科院自动化所研究团队提出的CityGaussianV2算法,该算法用于大规模复杂三维场景的高效重建,已接受于ICLR 2025,并开源代码。

1. 背景与挑战

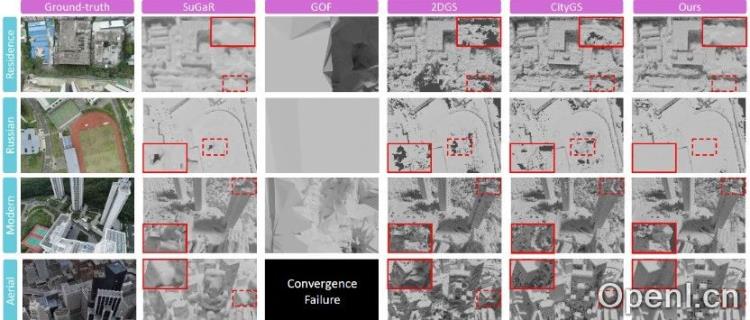

三维场景重建旨在从图像恢复场景的三维结构,追求精准几何和逼真渲染。3D Gaussian Splatting (3DGS)因其效率优势成为主流,但其离散表征难以精确拟合物体表面,重建几何精度不足。SuGaR、2DGS、GOF等改进算法在小场景表现出色,但在大型复杂场景中面临更大挑战,例如几何精度下降、显存、训练耗时过长等问题,且缺乏有效的几何重建质量评估手段。

2. CityGaussianV2算法介绍

CityGaussianV2继承了CityGaussian的子模型划分和数据分配方案,并使用2DGS作为基元。针对大规模场景重建的挑战,它主要进行了以下优化:

- 高斯基元优化:引入了基于延展率过滤和梯度解耦的稠密化技术,以及深度回归监督,有效解决了2DGS在大型场景中存在的模糊伪影、基元过度增长等问题,提升了重建精度和训练稳定性。

- 并行训练管线优化:合并了训练和压缩过程,删除冗余步骤,周期性地删除重要性低的基元,降低了显存和存储开销,加速了模型收敛速度,并提升了对低端设备的友好性。

- 大规模重建几何评估协议:基于点云的目击频次统计,设计了针对大规模场景欠观测区域的边界估计方案,有效规避了欠观测区域重建效果不稳定对指标的影响,使评估更客观公正。

3. 实验结果与分析

实验结果表明,CityGaussianV2在几何精度(精度P,召回率R,F1-Score)方面均优于现有算法,重建结果细节更准确、完整性更高,渲染质量也与CityGaussian V1相当。同时,CityGaussianV2有效解决了显存问题,显著减少了训练时间和显存开销,并能将大规模场景重建结果以约400M的体积存储。

4. 总结

CityGaussianV2算法针对大规模复杂场景高效精准重建的挑战,提出了一种基于2DGS基元、并行训练和高效压缩的解决方案。它解决了2DGS在大规模场景中的收敛速度和扩展能力问题,并建立了大规模场景下的几何精度评估基准。实验结果验证了该方法的效率、有效性和鲁棒性,为大规模三维场景重建提供了新的技术方案。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号