OmniHuman – 字节跳动推出的单张照片生成全身动态视频生成框架

OmniHuman是什么

OmniHuman是字节跳动推出的一种先进的多模态视频生成框架,能够根据单一的人类图像及信号(如音频、视频或两者的结合)生成栩栩如生的人类视频。该框架采用多模态条件混合训练策略,有效克服了以往方法因高质量数据稀缺而造成的性能瓶颈,支持多种宽高比的图像输入(涵盖肖像、半身和全身图像),并能够适应多种场景需求。OmniHuman在歌唱、对话和手势处理等多个领域表现优异,支持多种视觉和音频风格,能够利用音频、视频及其组合来生成高质量的视频内容。

OmniHuman的主要功能

- 多模态驱动的视频生成:

- 支持音频驱动(如对话、唱歌)和姿势驱动(如手势、动作),并可融合两者生成流畅自然的人类动作视频。

- 兼容多种输入形式,包括面部特写、半身像、全身像,适应不同比例和风格的图像。

- 高逼真度与多样化动作:

- 生成的视频在视觉效果上高度真实,具备自然的面部表情、肢体动作和流畅的动态表现。

- 能够处理复杂动作和物体交互,例如在唱歌时演奏乐器、手势与物体之间的自然互动等。

- 灵活的视频生成:

- 支持任意宽高比和时长的视频生成,根据输入信号生成不同长度的视频片段。

- 兼容多种图像风格,包括写实、卡通和风格化的人物表现。

- 多场景适应性:在各种环境中生成高质量视频,涵盖不同的背景、光照条件和摄像角度。

OmniHuman的技术原理

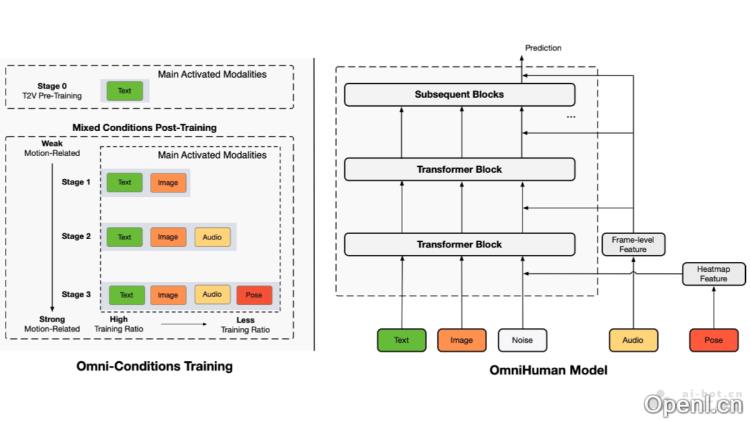

- 混合条件训练策略:

- 多条件融合:将文本、音频和姿势等多种相关条件混合于训练过程中,以减少数据选择的浪费,充分利用不同条件之间的互补性。

- 分阶段训练:基于三阶段的训练策略,逐步引入不同条件(文本、音频、姿势),根据条件的强弱调整训练比例,从而优化模型的泛化能力。

- 训练原则:更强条件的任务需要使用较弱条件的任务及其对应数据,以扩大数据规模。条件越强,训练比例应越低,以避免模型过度依赖于强条件。

- 扩散变换器架构:

- 基于DiT的模型:OmniHuman基于先进的视频生成模型架构DiT,利用因果3DVAE将视频投影至潜在空间,并以流匹配作为训练目标。

- 条件注入:

- 音频条件:通过wav2vec模型提取音频特征,并将其与视频帧特征结合,生成音频令牌,基于交叉注意力机制注入至模型中。

- 姿势条件:利用姿势引导器处理姿势条件,将姿势热图特征与视频帧特征结合,生成姿势令牌,连同噪声潜在表示一起输入模型。

- 文本条件:保留DiT架构中的文本分支,用于描述生成视频的内容。

- 参考条件处理:采用创新的参考条件策略,通过修改3D旋转位置嵌入,将参考图像特征与视频特征融合,无需额外的网络模块。

- 推理策略:

- 分类器引导(CFG):在推理过程中,对音频和文本条件应用CFG策略,通过逐步降低CFG强度,平衡表达性与计算效率,减少生成视频中的瑕疵。

- 长视频生成:使用上一个视频片段的最后几帧作为帧,确保长视频生成中的时间连贯性和身份一致性。

OmniHuman的项目地址

OmniHuman的应用场景

- 影视与娱乐:生成虚拟角色动画、虚拟主播和音乐视频等,提升内容创作的效率和视觉吸引力。

- 游戏开发:为游戏角色和非玩家角色(NPC)生成自然动作,增强游戏的沉浸感和互动性。

- 教育与培训:创建虚拟教师和模拟训练视频,辅助语言学习与职业技能培训。

- 广告与营销:生成个性化广告和品牌推广视频,提升用户参与度和内容吸引力。

- 社交媒体与内容创作:帮助创作者快速生成高质量短视频,支持互动视频创作,增加内容的趣味性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号