本文探讨了外部慢思考在LLM推理中的作用机制,为理解外部慢思考方法提供了理论支撑,并为优化LLM的推理能力提供了新思路。

原标题:人大刘勇团队「慢思考」机理分析:从雪球误差到正确推理概率

文章来源:机器之心

内容字数:16843字

大语言模型推理能力提升:从“慢思考”到理论框架

本文探讨了大语言模型(LLMs)推理能力提升的新方向——“慢思考”(Slow-Thinking)策略,特别是外部慢思考方法。文章基于论文“Rethinking External Slow-Thinking: From Snowball Errors to Probability of Correct Reasoning” (arxiv.org/abs/2501.15602),深入剖析了其理论基础、机制以及对LLM推理能力的影响。

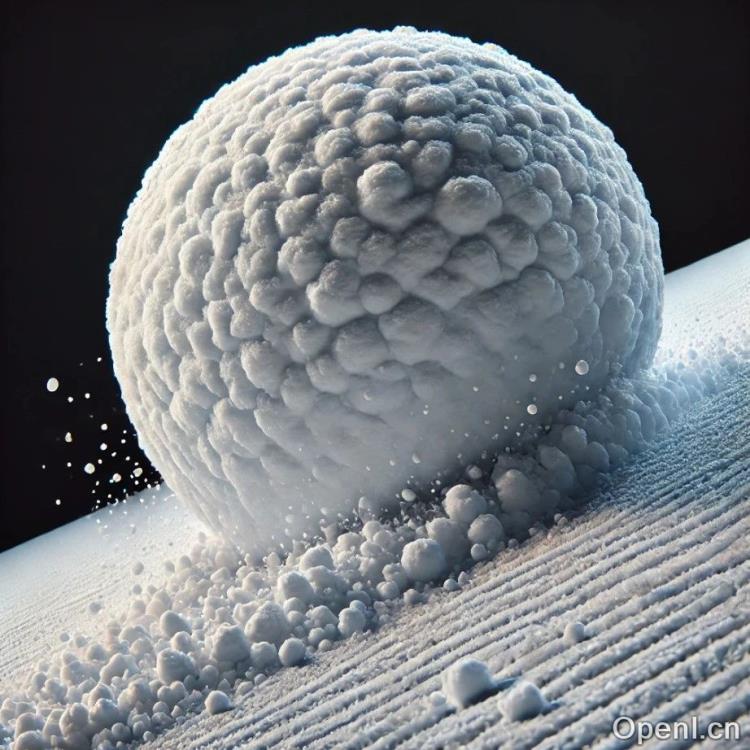

1. LLM推理中的“雪球误差”

文章首先指出,LLMs在推理过程中存在“雪球误差”效应。类似于雪球越滚越大,LLMs的微小错误会在自回归的推理过程中不断累积放大,最终导致严重偏差。这种误差累积源于LLM逐步执行一系列原始任务,前一步的错误会影响后续步骤,最终偏离正确答案。文章利用柏拉图的“洞穴寓言”形象地解释了这种现象:LLM的推理输出只是其内部推理过程的“影子”,受限于其从训练数据中学到的模式和误差。

2. 信息论视角下的推理错误概率

为了量化雪球误差,文章引入了互信息(MI)来衡量隐式推理序列与最终生成回复之间的共享信息量。信息损失被定义为互信息与隐式推理过程的信息熵之差,雪球误差则为所有推理步骤上信息损失的累积。文章进一步建立了雪球误差与推理错误概率之间的数系,证明了推理错误概率的下界随推理步数线性增长,甚至可能指数级增长,解释了LLM在长链推理任务中容易出错的原因。实验结果验证了这一理论,在GSM8k数据集上,三款先进的LLM的互信息均随推理路径长度呈负指数级下降。

3. 外部慢思考提升推理质量的机理

文章分析了外部慢思考方法提升LLM推理质量的机理。外部慢思考方法主要通过宽度扩展(如BoN、CoT-SC、ToT、MCTS)和生成与选择(从多个候选推理路径中选择最优解)来提高生成正确答案的概率。文章利用信息论方法,推导出在雪球误差存在时,获得正确推理结果的概率公式,并以Beam Search为例,分析了宽度扩展与选择可靠性之间的平衡关系,指出价值函数的可靠性至关重要。

4. BoN与MCTS方法的对比

文章对比了BoN和MCTS两种外部慢思考方法。理论分析和实验结果表明,在推理正确率相当的情况下,BoN的总推理成本与MCTS接近,甚至在某些情况下更低。实验结果显示,在GSM8k和PrOntoQA两个数据集上,通过适当调整参数,BoN能够达到甚至超越MCTS的推理效果。

5. 结论

文章总结指出,外部慢思考方法通过扩展推理空间来减少雪球误差,但需要在正确性和计算开销之间权衡。价值函数的可靠性和推理总成本是影响其有效性的关键因素。优化奖励函数和提升策略模型的推理能力是未来改进外部慢思考方法的关键方向。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号