HumanDiT – 浙大联合字节推出的姿态引导人体视频生成框架

HumanDiT是什么

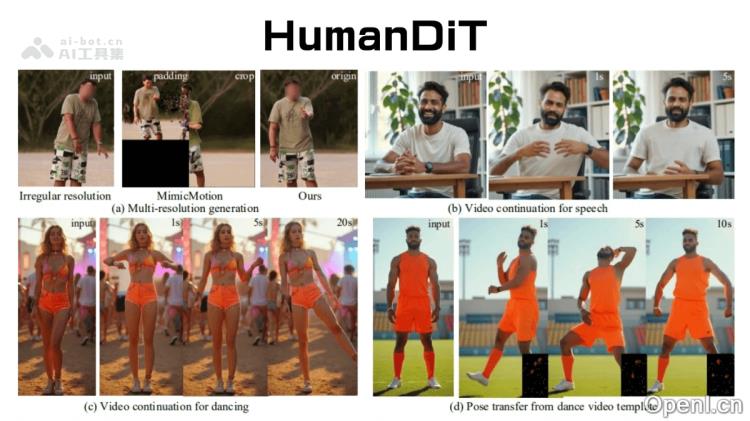

HumanDiT 是由浙江大学与字节跳动共同开发的一种高保真姿态引导人体视频生成框架。该框架基于扩散变换器(Diffusion Transformer,DiT),能够在大规模数据集上进行训练,从而生成具有精细身体渲染的长序列人体视频。HumanDiT 的最大优势在于其姿态引导机制,通过关键点扩散变换器(Keypoint-DiT)生成后续姿态序列,确保视频中人物动作的自然流畅。同时,它引入了前缀潜在参考策略,以在长序列中保持个性化特征。该框架支持多种视频分辨率和可变序列长度,特别适合于长序列的视频生成。同时,基于姿态适配器的功能使得给定序列的姿态转移更加精准,进一步提高了姿态对齐的准确性。

HumanDiT的主要功能

- 姿态引导的视频生成:HumanDiT 利用关键点扩散变换器(Keypoint-DiT)生成后续的姿态序列,确保视频中人物动作的一致性和自然性。

- 长序列视频生成:支持多种分辨率和可变长度的序列,适合制作高质量的长序列视频。

- 个性化特征保持:通过前缀潜在参考策略,确保在长序列中保持独特的个性化特征。

- 灵活的输入与输出:能够从单张静态图像或现有视频中继续生成新的视频,适用于多种实际应用场景。

- 姿态适配与细化:通过姿态适配器实现给定序列的姿态转移,利用姿态细化模块提升面部和手部特征与参考图像的对齐。

HumanDiT的技术原理

- 姿态引导与扩散变换器:HumanDiT 通过姿态引导生成视频,利用关键点扩散变换器(Keypoint-DiT)在推理时生成后续的姿态序列,确保视频中的人体动作连贯自然,同时具备处理不同分辨率和序列长度的能力。

- 前缀潜在参考策略:为在长序列视频生成中保持个性化特征,HumanDiT 引入了前缀潜在参考策略,该策略通过将视频的第一帧作为无噪声的前缀潜在向量,供模型在生成过程中参考,以保持视觉一致性。

- 姿态适配器与姿态细化模块:HumanDiT 利用姿态适配器实现给定序列的姿态转移,并通过姿态细化模块进一步优化生成的姿态序列,提高面部和手部等细节的生成质量,确保与参考图像的精准对齐。

- 大规模数据集训练:HumanDiT 在一个包含 14000 小时高质量视频的大型数据集上进行训练,这些数据经过结构化处理,涵盖多样的人类动作场景,使模型具备丰富的先验,从而在推理过程中表现出卓越的泛化能力。

HumanDiT的项目地址

HumanDiT的应用场景

- 虚拟人:HumanDiT 可用于生成虚拟人的动态视频,使其动作更加自然流畅。在虚拟客服场景中,虚拟人能够根据用户的提问实时生成相应的动作和表情,提供更生动、逼真的交互体验。

- 动画电影:HumanDiT 能够生成高质量的长序列人体视频,适用于动画角色的动作序列生成,帮助动画师快速创作高质量的段,提升制作效率。

- 沉浸式体验:HumanDiT 可用于构建沉浸式体验中的虚拟角色和动作。在沉浸式 VR 体验中,HumanDiT 能生成与场景匹配的人物动作和表情,令参与者感受更加真实生动的体验。

- 视频生成与续写:能够从单张图像中生成视频,或从现有视频中继续生成内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号