Distillation Scaling Laws.

原标题:苹果也在蒸馏大模型,给出了蒸馏Scaling Laws

文章来源:机器之心

内容字数:4957字

苹果研究揭示蒸馏扩展定律:量化估算蒸馏模型性能

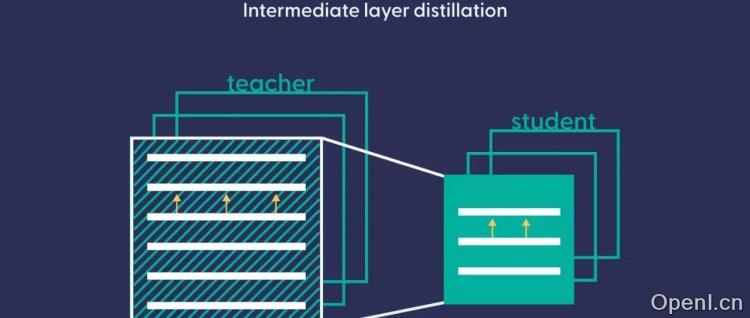

机器之心近日报道了苹果研究人员提出的蒸馏扩展定律(Distillation Scaling Laws),该定律为量化估算知识蒸馏模型的性能提供了理论依据。知识蒸馏作为大模型领域的重要技术,能够在压缩模型体积的同时保持性能,甚至提升精度和降低时延。苹果的研究则更进一步,通过该定律,我们可以根据计算预算及其在教师和学生模型之间的分配来预测蒸馏模型的性能。

1. 蒸馏扩展定律的核心内容

蒸馏扩展定律基于大规模实验,研究了教师模型大小(N_T)、教师训练token数量(D_T)、学生模型大小(N_S)和学生训练token数量(D_S)对学生模型性能(交叉熵L_S)的影响。研究发现,学生模型的交叉熵可以由蒸馏扩展定律预测,而教师模型的交叉熵L_T(N_T,D_T)起着关键作用。 L_T对L_S的影响遵循幂律关系,这种关系体现了“能力差距”现象:过强的教师模型反而可能导致学生模型性能较差。该定律还考虑了教师模型的预训练成本,为计算资源的最佳分配提供了指导。

2. 实验设计与结果

为了得出蒸馏扩展定律,苹果研究人员进行了大规模实验,涵盖了参数范围从1.43亿到126亿的教师和学生模型,以及高达5120亿token的训练数据。实验设计采用多种方案,包括固定教师模型变化学生模型,以及固定学生模型变化教师模型等,以全面考察各种因素的影响。实验结果表明,在特定条件下,学生模型可以超越教师模型的性能,展现出“弱到强”的泛化能力。

3. 蒸馏与监督学习的比较

研究比较了蒸馏和监督学习在不同计算预算下的性能。结果显示,当教师模型已存在或具有多用途时,且学生模型的计算资源不超过定律给出的阈值,蒸馏的效率高于监督学习。反之,则监督学习更有效。

4. 蒸馏扩展定律的意义

蒸馏扩展定律的提出,降低了大规模使用知识蒸馏的风险,为优化教师和学生模型的计算资源分配提供了理论指导。该定律为构建更小、更强大、推理成本更低的模型提供了路线图,并增强了测试时扩展的可行性。这项研究是目前已知最大规模的蒸馏受控实证研究,为知识蒸馏领域提供了重要的理论和实践指导。

联系作者

文章来源:机器之心

作者微信:

作者简介:专业的人工智能媒体和产业服务平台

粤公网安备 44011502001135号

粤公网安备 44011502001135号