原标题:我终于找到了高并发的极速DeepSeek-R1满血版API,我被火山香到了

文章来源:夕小瑶科技说

内容字数:6196字

DeepSeek R1 云服务拼:火山引擎的“王炸”组合

近期DeepSeek R1模型的火爆,引发了各大云厂商的激烈竞争,纷纷推出自家版本的R1模型并提供大幅优惠。然而,许多云厂商提供的免费或打折服务,却在Tokens Per Minute (TPM) 上设置了极低的限制,例如1万左右,严重限制了模型的实际应用场景。

TPM限制的困境

文章指出,由于DeepSeek R1模型每次提问的Token消耗量较大(平均约4000 Tokens),低TPM限制导致每分钟平均提问次数极低(例如TPM为1万时,每分钟仅能提问2.5次),几乎无法满足实际应用场景的并发需求,这使得许多开发者转向本地部署。

火山引擎的突破

文章重点介绍了火山引擎的DeepSeek-R1服务,其将TPM限制提升至500万,每分钟可支持500-1250次提问,实现了高并发能力。作者亲测了火山引擎的R1模型,并从效果、吞吐率和首字延迟三个维度进行了详细评估。

效果测试:验证671B满血版

作者通过提问具有挑战性的问题(例如解读网络梗),验证了火山引擎提供的R1模型确实是671B的满血版本,其回答质量与DeepSeek官方一致,远超其他厂商提供的蒸馏版本。

性能测试:高吞吐率和低首字延迟

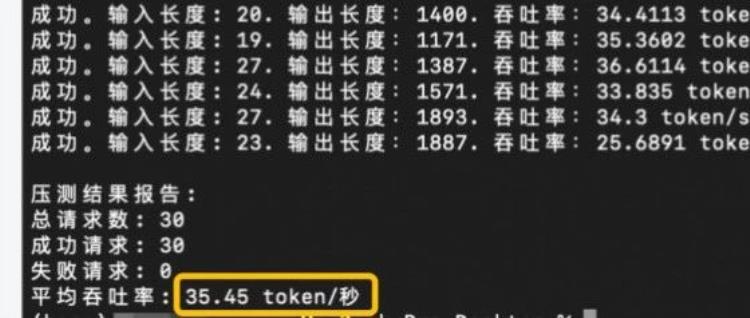

作者对火山引擎R1模型的吞吐率进行了测试,结果显示其达到了35.4 tokens/s,远高于市面上的其他R1 API。同时,首字延迟也低至0.39秒,保证了良好的用户体验。压测结果显示,在TPM未被打爆的情况下,成功率达到100%。作者提醒读者,高并发环境下需要适当调整ReadTimeOut参数。

联网搜索插件的优势

文章还介绍了火山引擎提供的联网搜索插件,允许用户为DeepSeek-R1模型赋予联网搜索能力,进一步增强模型的功能。用户可以在应用实验室中创建基于DeepSeek-R1的应用,并启用该插件。

总结

文章总结道,火山引擎的DeepSeek-R1服务在高并发、高吞吐率和低首字延迟方面表现出色,是目前市场上少有的能够满足实际应用场景需求的满血版R1 API。作者强烈推荐开发者尝试使用火山引擎的DeepSeek-R1服务。

联系作者

文章来源:夕小瑶科技说

作者微信:

作者简介:低负担解码AI世界,硬核也可爱!聚集35万AI发烧友、开发者和从业者,广泛覆盖互联网大厂中高管、AI公司创始人和机构投资人。一线作者来自清北、国内外顶级AI实验室和大厂,兼备敏锐的行业嗅觉和洞察深度。商务合作:zym5189

粤公网安备 44011502001135号

粤公网安备 44011502001135号