相信属于RLer的时刻应该会到来的吧!

原标题:以RLer视角看DeepSeek训练中的强化学习

文章来源:智猩猩GenAI

内容字数:5933字

智猩猩AI新青年讲座:DeepSeek R1与推理模型专题

本文总结了知乎文章《DeepScaleR:强化学习让小模型推理超越o1-preview》,该文由南栖仙策算法副总裁赵鉴博士授权发布,探讨了强化学习在大模型训练中的应用,特别是DeepSeek模型的训练过程。

1. 大模型训练的问题定义

文章指出,现有文献很少明确定义大模型训练的问题。作者尝试从现有信息中提炼出问题定义:输入为自监督+SFT训练好的初始模型和人类偏好数据(Q,A1,A2),问题库(Q);输出为一个新模型。作者进一步简化,将输入替换为基于人类偏好数据训练好的奖励模型和问题库(Q),输出为一个模型。这与传统强化学习问题定义有所不同,后者包含状态转移函数,而大模型训练中状态转移函数不明确。

2. 大模型中的问题建模

文章探讨了两种大模型问题建模方式:第一种将状态定义为问题Q,动作定义为生成回答中的下一个token,奖励为最后一步的奖励;第二种将状态定义为问题Q,动作定义为回答A,奖励为一步决策的奖励。作者认为,第二种建模方式更常见,但并非严格的强化学习问题,因为它缺少序列决策过程。作者将此类方法类比于早期将强化学习应用于CV或NLP任务的做法,直接使用不可导的评价指标作为奖励进行优化。

3. DeepSeek训练中使用的强化学习算法(GRPO)

文章分析了DeepSeek训练中使用的GRPO算法。作者认为GRPO可以理解为策略梯度算法Reinforce的改进版本,结合了PPO算法中对公式后半项的改进,但并非一个非常创新的算法。GRPO通过多次采样,解决了传统强化学习环境中单次采样的限制,并由于大模型环境的确定性,避免了使用价值网络和方差减小策略。

4. 强化学习在大模型中的应用与展望

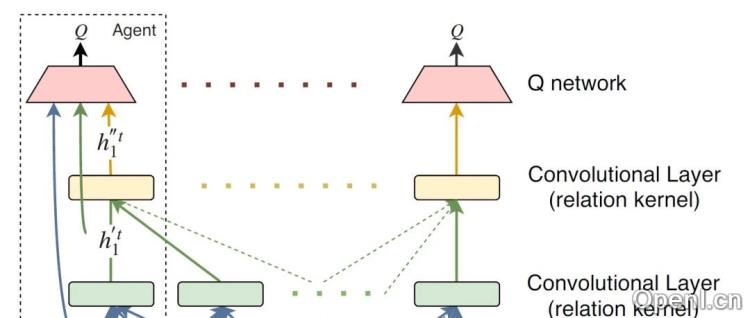

文章最后探讨了强化学习在大模型训练中的应用现状,指出目前只有少数RLer参与核心工作。作者建议,RLer应更多地从问题定义出发,例如将01稀疏奖励问题建模为类似围棋的模式,才能更好地发挥RL算法的优势。同时,推理侧可以结合MCTS等技术。文章以游戏AI为例,说明了高阶RL算法工程师在实际应用中并非总是必需的。

总而言之,文章深入浅出地分析了强化学习在大模型训练中的应用,特别是DeepSeek模型的训练过程,并对强化学习算法工程师未来的发展方向提出了建议。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下账号,专注于生成式人工智能,主要分享技术文章、论文成果与产品信息。

粤公网安备 44011502001135号

粤公网安备 44011502001135号