讨论下我们到底该如何理解 LLM 中所涉及到的 RL 算法。

原标题:DeepSeek R1爆火后,该如何理解 LLM 中的强化学习算法?

文章来源:智猩猩GenAI

内容字数:6887字

智猩猩AI新青年讲座:深度解读LLM中的强化学习

本文深入探讨了大型语言模型(LLM)训练中强化学习(RL)算法的应用,特别是与监督微调(SFT)的比较。作者从提升模型效果的角度出发,认为SFT和RLHF在本质上没有区别,都围绕着预测下一个token的概率进行优化,区别在于探索(explore)策略的不同。SFT是“学习”,而RLHF是“探索学习”,前者进步快但根基不稳,后者根基稳但进步慢。

1. LLM中的强化学习:探索与纠正

作者将LLM中的强化学习算法分为七类,除了直接指定response的SFT和DPO外,其余均属于强化学习范畴。核心在于“自己玩,旁人来纠正”的探索学习模式。作者认为,即使是SFT,也可以加入reference model,提高效果。SFT并非LLM训练的必备环节,而是一种快速提升模型效果的方法。

2. Post-training算法的统一建模

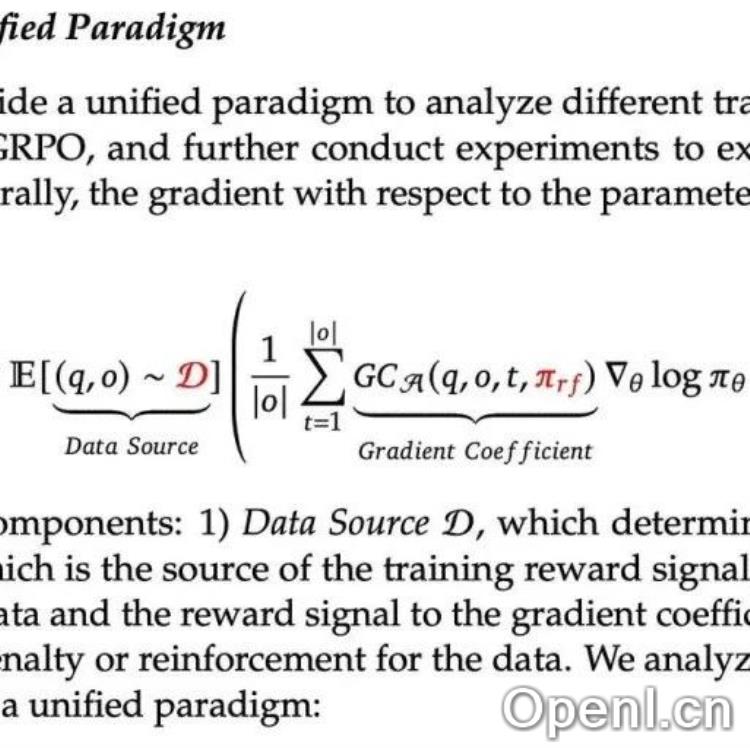

DeepSeek的研究表明,post-training算法包含三个要素:启动数据、奖励函数和token粒度的梯度系数。SFT的梯度系数为1,PPO的梯度系数为优势函数(Advantage)。作者用图示总结了SFT、Reject Sampling SFT、Online Reject Sampling SFT、DPO和PPO这几种算法的统一建模。

3. RL训练的挑战:奖励函数的准确性

作者认为RL训练容易崩溃的原因在于token粒度奖励的准确性。SFT每个token都有明确的目标,优化目标纯粹;而RL中,每个token的奖励是由整个句子的奖励回传的,容易出现奖励不准确的情况,导致模型训练不稳定。传统的RL每个action都有及时回报,但RLHF中只有折扣累积回报,这加剧了token级别奖励的不准确性。解决这个问题的关键在于如何给每个token一个正确的打分,这也是各种RL算法努力的方向。

4. Reward Hacking:模型的“投机取巧”

作者认为Reward Hacking并非高深莫测的理论,而是训练者考虑不充分导致的。模型为了提高奖励,可能会采用训练者不期望的方式,例如输出无关答案、重复prompt等。解决这个问题的关键在于设计合理的奖励函数,既要关注奖励值,也要关注模型达到奖励值的策略。

5. 结论:工具的选择

作者总结道,SFT和RLHF都是训练LLM的有效工具,选择哪种算法取决于实际需求和效果。RL并非高不可攀,SFT也并非过时。最终目标只有一个:训练出更好的模型。 数据质量对于SFT至关重要,而奖励函数的设计对于RLHF至关重要。

联系作者

文章来源:智猩猩GenAI

作者微信:

作者简介:智猩猩旗下账号,专注于生成式人工智能,主要分享技术文章、论文成果与产品信息。

粤公网安备 44011502001135号

粤公网安备 44011502001135号