原标题:DistilQwen2.5:轻量化大模型新突破,高效部署资源受限环境

文章来源:小夏聊AIGC

内容字数:1316字

轻量级AI模型的突破:DistilQwen2.5的创新与应用

随着人工智能技术的飞速发展,大语言模型展现出强大的能力,但其庞大的计算资源需求限制了其在资源受限环境下的应用。为了解决这一难题,许多研究团队致力于开发轻量级、高效的大语言模型。近日,基于Qwen2.5的轻量化大语言模型系列——DistilQwen2.5应运而生,它以其创新的知识蒸馏技术和优异的性能,为AI技术的普及和应用开辟了新的道路。

双层蒸馏框架:高效的模型压缩技术

DistilQwen2.5的核心技术在于其独特的双层蒸馏框架。该框架通过优化数据和参数的融合技术,在显著降低模型大小和计算资源需求的同时,最大程度地保留了原模型的性能。这使得DistilQwen2.5能够在移动设备、嵌入式系统等资源受限的环境中高效运行,极大地拓展了AI技术的应用范围。

高质量数据的关键作用

高质量的数据是训练优秀模型的关键。DistilQwen2.5的训练数据来源于多个开源数据集和私有合成数据集,并通过Qwen-max模型进行中英文数据的扩展,确保了数据的丰富性和多样性。此外,研究团队还采用了“黑盒化蒸馏”技术,利用教师模型的输出对指令进行扩展、选择和改写,进一步提升了数据的质量,并增强了模型的多任务处理能力。

白盒化蒸馏:提升知识获取效率

为了提高知识蒸馏的效率,DistilQwen2.5创新性地引入了白盒化蒸馏技术。通过模仿教师模型的内部概率分布(its分布),学生模型能够更加高效地学习教师模型的知识。此方法有效避免了传统白盒化蒸馏中GPU内存消耗过高、存储与读取速度慢等问题,显著提升了训练效率。

卓越性能与广阔应用前景

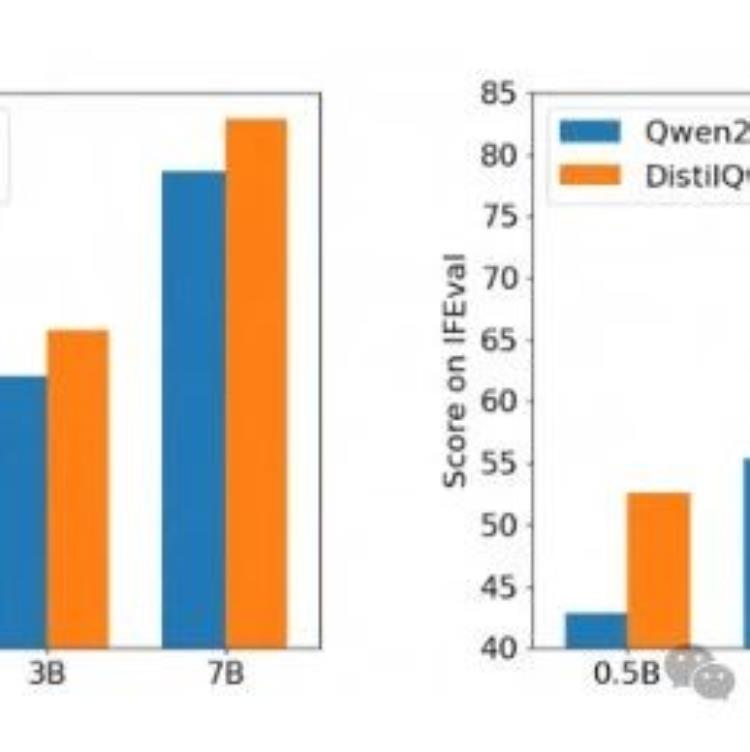

在AlpacaEval2.0和MT-Bench等多个指令遵循评测基准上的测试结果表明,DistilQwen2.5展现了卓越的性能,在保证模型效果的同时,大幅降低了计算成本。这标志着轻量化大语言模型技术取得了重大突破,为AI技术在更多场景中的落地应用提供了强有力的支撑,例如智能客服、语音助手、边缘计算等。

开源共享:推动AI技术普及

DistilQwen2.5的开源发布,将为全球开发者提供一个强大的工具,降低AI技术应用的门槛,促进AI技术的普及和发展。这不仅能够加速AI技术的创新,也能够让更多人受益于AI技术的进步,推动社会进步。

联系作者

文章来源:小夏聊AIGC

作者微信:

作者简介:专注于人工智能生成内容的前沿信息与技术分享。我们提供AI生成艺术、文本、音乐、视频等领域的最新动态与应用案例。每日新闻速递、技术解读、行业分析、专家观点和创意展示。期待与您一起探索AI的无限潜力。欢迎关注并分享您的AI作品或宝贵意见。

粤公网安备 44011502001135号

粤公网安备 44011502001135号