SpatialVLA – 上海 AI Lab 联合上科大等推出的空间具身通用操作模型

SpatialVLA是什么

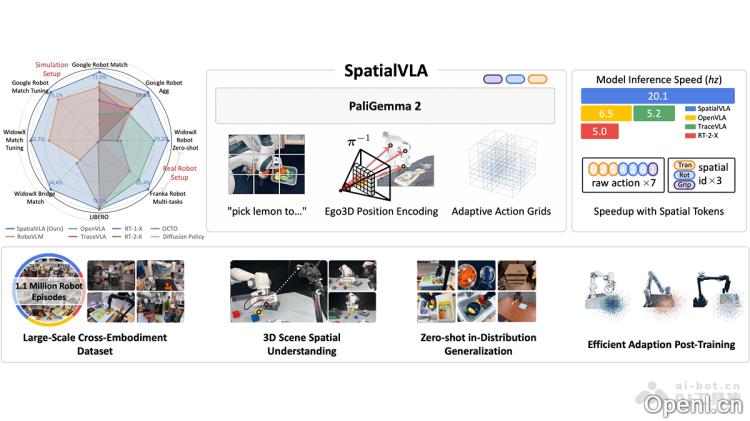

SpatialVLA 是由上海 AI Lab、中国电信人工智能研究院和上海科技大学等多家机构联合开发的先进空间具身通用操作模型。这一模型依托于百万级真实数据进行预训练,赋予机器人出色的3D空间理解能力。通过Ego3D位置编码,SpatialVLA 将3D空间信息与语义特征进行有效融合,并采用自适应动作网格实现连续动作的离散化,从而能够在多个机器人平台上实现广泛的控制和操作。SpatialVLA 在大规模真实机器人数据上经过预训练,展示出卓越的零样本泛化能力和空间理解能力,特别适合在复杂环境和多任务场景中应用。其开源代码及灵活的微调机制为机器人领域的研究与应用开辟了全新的技术路径。

SpatialVLA的主要功能

- 零样本泛化控制:能够在未曾遇到的机器人任务和环境中直接执行操作,无需进行额外的训练。

- 高效适应新场景:通过少量数据的微调,迅速适应新的机器人平台或任务要求。

- 强大的空间理解能力:具备理解复杂3D空间布局的能力,能够精准执行物体定位、抓取和放置等操作任务。

- 跨机器人平台的通用性:支持多种类型和配置的机器人,实现统一的操作策略。

- 快速推理与高效动作生成:基于离散化的动作空间,提升模型的推理速度,适合实时的机器人控制。

SpatialVLA的技术原理

- Ego3D位置编码:将深度信息与二维语义特征结合,构建以机器人为中心的3D坐标系,消除对特定机器人-相机校准的依赖,使模型能够适应不同机器人平台的3D场景结构。

- 自适应动作网格:将连续的机器人动作离散化为自适应网格,依据数据分布划分动作空间。不同机器人的动作用网格进行对齐,实现跨平台的动作泛化与迁移。

- 空间嵌入适应:在微调阶段,根据新机器人的动作分布重新划分网格,调整空间嵌入,提供灵活且高效的后训练方法,助力模型在新环境中的快速适应。

- 预训练与微调:在大规模真实机器人数据上进行预训练,学习通用操作策略,并在新任务或机器人平台上进行微调,以进一步提升模型性能。

SpatialVLA的项目地址

- 项目官网:https://spatialvla.github.io/

- GitHub仓库:https://github.com/SpatialVLA/SpatialVLA

- HuggingFace模型库:https://huggingface.co/IPEC-COMMUNITY/foundation-vision-language-action-model

- arXiv技术论文:https://arxiv.org/pdf/2501.15830

SpatialVLA的应用场景

- 工业制造:广泛应用于自动化装配和零件搬运,能够快速适应不同的生产线,显著提升生产效率。

- 物流仓储:精准抓取和搬运货物,能够适应动态的环境,从而优化物流效率。

- 服务行业:执行递送、清洁及整理等任务,理解自然语言指令,适应复杂的环境。

- 医疗辅助:用于传递手术器械和搬运药品,确保操作的精准性和安全性。

- 教育与研究:支持新机器人应用的快速开发与测试,助力学术研究的进展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号