DiffBrush – 北邮联合清华等机构推出的图像生成与编辑框架

DiffBrush是什么

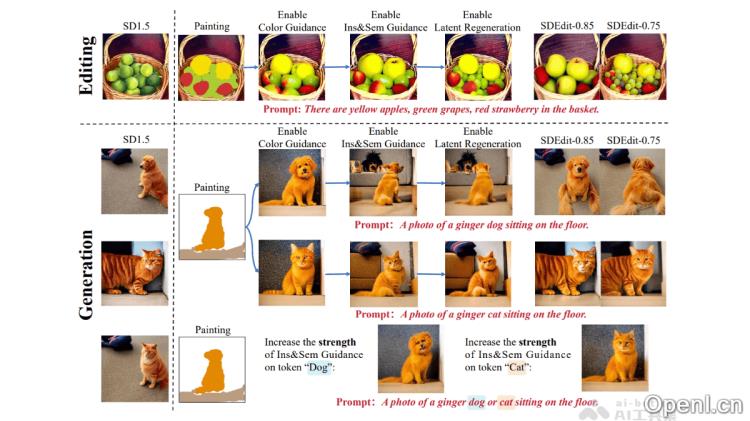

DiffBrush是由北京邮电大学、清华大学、中国电信人工智能研究所和西北工业大合开发的一款图像生成与编辑框架。用户无需进行复杂的训练,即可通过简单的手绘草图直观地操控图像生成过程。该工具利用预训练的文本到图像(T2I)模型,结合颜色引导、实例及语义引导、潜在空间再生等先进技术,精确地掌控生成图像的颜色、语义及实例分布。DiffBrush兼容多种T2I模型(如Stable Diffusion、SDXL等),并支持LoRA风格调整。用户在画布上轻松绘制实例的轮廓和颜色,即可生成符合其需求的图像。DiffBrush有效地克服了传统T2I模型对文本提示的依赖,提高了AI绘画的可用性,为用户提供了更为直观和高效的创作体验。

DiffBrush的主要功能

- 用户友好的图像生成:用户可以通过手绘草图来控制生成图像的内容,无需掌握复杂的文本提示或技术知识。

- 颜色控制:根据用户绘制的颜色信息,精确控制生成图像中相应区域的颜色。

- 实例与语义控制:用户可以绘制实例的轮廓并标注语义信息,以控制生成图像中特定对象的位置和语义属性。

- 图像编辑:允许用户在现有图像的基础上进行编辑,如添加、修改或替换图像中的对象。

- 风格化生成:支持与LoRA(低秩自适应)风格调整结合,生成不同艺术风格的图像,如油画、国画等。

- 多模型兼容:兼容多种T2I模型(如Stable Diffusion、SDXL、Flux等),具备广泛的适用性。

DiffBrush的技术原理

- 扩散模型的引导机制:基于预训练的T2I模型(如Stable Diffusion)的扩散过程,DiffBrush通过修改去噪方向,引导生成图像朝向用户手绘的草图靠拢。

- 颜色引导:通过扩散模型的潜在空间与颜色空间的高度相似性,用户绘制的颜色信息被编码到潜在空间中,利用能量函数(如MSE损失)引导生成图像的颜色与用户的需求一致。

- 实例与语义引导:利用扩散模型中的注意力机制(如交叉注意力和自注意力),根据用户绘制的实例轮廓作为监督目标,调整注意力图的分布,确保生成图像中对象的位置和语义符合用户需求。

- 潜在空间再生:通过迭代优化初始噪声分布,使其接近用户手绘草图的目标分布,从而在扩散过程的早期阶段进一步提升生成图像的质量。

- 用户交互与兼容性:将用户的手绘草图与文本提示结合,提供简单的用户界面以实现直观交互。DiffBrush支持多种预训练的T2I模型,用户可根据需要调整引导强度等超参数,以获得最佳生成效果。

DiffBrush的项目地址

- arXiv技术论文:https://arxiv.org/pdf/2502.20904

DiffBrush的应用场景

- 创意绘画:艺术家和设计师能够快速将手绘创意转化为高质量图像,支持多种风格,便于实现艺术构思。

- 图像编辑:用户可在已有图片上轻松添加、替换或修改内容,适合普通用户和设计师使用。

- 教育工具:可用于艺术与设计教学,帮助学生通过手绘理解色彩、构图和创意表达。

- 游戏设计:快速生成游戏场景、角色或动画草图,支持风格化输出,助力创意迭代。

- 广告设计:根据创意草图迅速生成广告图像,满足客户对色彩和布局的需求,提高设计效率。

常见问题

- DiffBrush如何使用?:用户只需在画布上手绘草图,并选择相应的颜色和样式,DiffBrush将自动生成符合需求的图像。

- DiffBrush支持哪些图像格式?:DiffBrush支持多种常见图像格式,用户可以根据需要导入和导出图像。

- 我可以在DiffBrush中使用自己的模型吗?:DiffBrush兼容多种预训练的T2I模型,用户可以根据需求选择适合的模型。

- DiffBrush适合哪些用户群体?:无论是艺术家、设计师,还是普通用户,DiffBrush都提供了友好的操作界面,适合各类人群使用。

- DiffBrush提供哪些技术支持?:用户可通过项目官网获取详细的使用文档和技术支持,帮助解决使用过程中的问题。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号