大家好,我是Cita(西塔),一位热衷于AI编程的程序员。我的愿景是在AI时代引领“氛围编程”的风潮,并帮助数万人掌握AI编程的奥秘。今天,我将向大家介绍一个强大的工具——WeKnora。

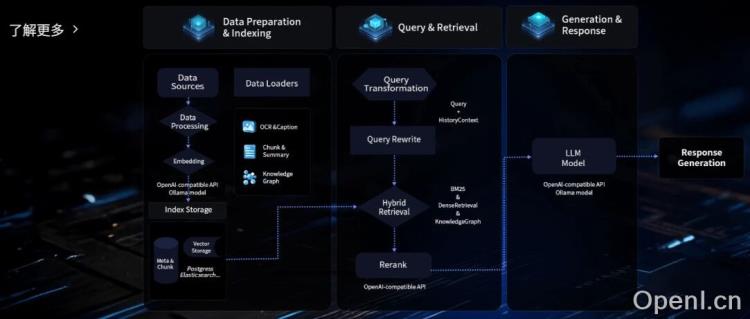

WeKnora,作为腾讯iMax知识库的开源版本,是一个基于大语言模型(LLM)的文档理解与语义检索框架,其核心技术正是当前备受瞩目的RAG(检索增强生成)。它提供了丰富而全面的API接口,涵盖了知识库管理的各个环节,从创建、更新到删除、查询,应有尽有。这意味着您可以轻松地将其集成到任何自动化流程中,实现知识库的自动化更新与维护,彻底告别繁琐的人工操作。

对于律师、医生、金融从业者以及企业核心研发或战略部门而言,数据安全是至关重要的考量。WeKnora完全支持私有化部署,您可以将其部署在本地计算机或公司内部网络,确保所有数据尽在您的掌控之中。

核心功能一览

WeKnora的功能强大且多样,能够满足您在文档处理和知识管理方面的多种需求。

格式兼容性

WeKnora支持几乎所有主流的文本文档格式,包括PDF、Word、TXT、Markdown等。更令人惊喜的是,它甚至能够处理PNG、JPG等图片格式的文档,极大地拓宽了其应用范围。

精准智能检索

该框架内置了先进的混合检索架构,巧妙地融合了向量检索、关键词检索等多种策略,能够实现高度精准的智能信息检索,让您快速找到所需内容。

灵活的模型集成

无论您倾向于使用Ollama本地部署的模型,还是偏爱云端的商业API(如阿里的通义千问),WeKnora都能轻松兼容,为您提供最大的灵活性。

私有化部署能力

WeKnora支持本地和私有云部署,能够有效保障您的数据安全,让您安心使用。

无缝对接微信生态

作为微信对话平台的核心框架之一,WeKnora能够无缝集成到公众号、小程序、企业微信等场景中,帮助您打造个性化的智能客服或AI助手。

快速上手指南

官方已经将WeKnora的部署流程简化到极致,即使是技术新手,也能轻松跟随指导快速完成部署。

在开始之前,请确保您的计算机已安装Docker、Docker Compose和Git。以下是简要的部署步骤:

克隆项目

首先,您需要克隆WeKnora的GitHub仓库:

git clone https://github.com/Tencent/WeKnora.git

进入项目目录:

cd WeKnora

配置环境变量

复制示例环境文件:

cp .env.example .env

根据.env文件中的注释,修改端口等配置信息,以避免潜在的冲突。

启动服务

您可以通过以下命令启动服务(包含Ollama和后端容器):

./scripts/start_all.sh

或者使用make命令:

make start-all

如果您需要单独启动Ollama服务,可以执行:

ollama serve > /dev/null 2>&1 &

使用Docker Compose启动服务:

docker compose up -d

停止服务

要停止服务,可以使用:

./scripts/start_all.sh --stop

或者使用make命令:

make stop-all

服务启动成功后,您可以在浏览器中访问http://localhost:8080,即可看到简洁的配置界面。按照引导完成大模型和嵌入模型的配置,您就可以开始体验WeKnora的强大功能了。

粤公网安备 44011502001135号

粤公网安备 44011502001135号