Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF官网

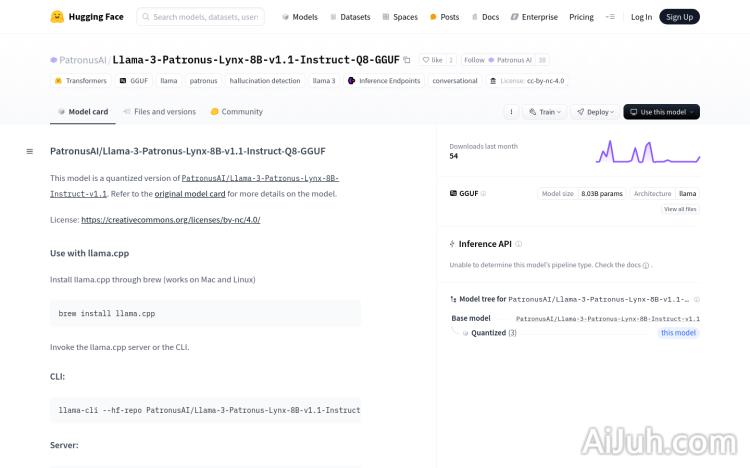

PatronusAI/Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF是一个基于Llama模型的量化版本,专为对话和幻觉检测设计。该模型使用了GGUF格式,拥有8.03亿参数,属于大型语言模型。它的重要性在于能够提供高质量的对话生成和幻觉检测能力,同时保持模型的高效运行。该模型是基于Transformers库和GGUF技术构建的,适用于需要高性能对话系统和内容生成的应用场景。

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF是什么

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF 是一个基于 Llama 模型的量化大型语言模型 (LLM),参数量为 8.03 亿。它特别针对对话生成和幻觉检测进行了优化,并使用 GGUF 格式进行存储,方便在各种平台上部署。该模型利用 Transformers 库构建,旨在提供高效且高质量的自然语言处理能力。

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF的主要功能

该模型主要具备两大核心功能:对话生成和幻觉检测。对话生成方面,它可以生成流畅自然的对话文本,适用于构建机器人、虚拟助手等应用。幻觉检测功能则可以有效识别和过滤模型生成的虚假或不准确信息,提升模型的可靠性。此外,由于采用了量化技术和 GGUF 格式,该模型运行效率高,兼容性强。

如何使用Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF

使用该模型需要一定的技术基础。首先需要安装 llama.cpp (支持 Mac 和 Linux 系统),然后启动 llama.cpp 服务器或命令行界面 (CLI)。之后,通过 llama-cli 或 llama-server 命令行工具运行模型推理。 具体步骤包括:克隆 llama.cpp 项目,使用 `LLAMA_CURL=1` 标志构建项目,最后运行构建好的 llama-cli 或 llama-server 进行模型推理。

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF的产品价格

本文未提供该模型的价格信息。建议访问 Hugging Face 等平台查看其相关信息,或联系模型开发者 PatronusAI 获取报价。

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF的常见问题

该模型的硬件需求是什么? 模型的硬件需求取决于使用的具体方法和推理规模。 一般来说,至少需要一个具有足够显存的 GPU 来运行。更小的模型(量化后)可能在 CPU 上也能运行,但速度会慢很多。

如何评估该模型的幻觉检测能力? 可以使用专门的幻觉检测数据集对模型进行评估,并通过指标(如精确率、召回率等)来衡量其性能。 也可以设计一些具有挑战性的测试用例来人工评估。

该模型支持哪些编程语言? 该模型本身不直接支持特定的编程语言。 它的使用依赖于 llama.cpp,而 llama.cpp 的接口通常通过 C++ 来访问。 但你可以使用其他语言 (如 Python) 通过调用 llama.cpp 的接口来间接使用该模型。

Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF官网入口网址

https://huggingface.co/PatronusAI/Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF

OpenI小编发现Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF网站非常受用户欢迎,请访问Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF网址入口试用。

数据评估

本站OpenI提供的Llama-3-Patronus-Lynx-8B-v1.1-Instruct-Q8-GGUF都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 9日 下午12:13收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号