Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF官网

该模型是量化版大型语言模型,采用4位量化技术,降低存储与计算需求,适用于自然语言处理,参数量8.03B,免费且可用于非商业用途,适合资源受限环境下高性能语言应用需求者。

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF是什么

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF是一个基于Llama 3架构的量化大型语言模型。它采用4位量化技术,将模型参数压缩,从而降低了存储和计算需求。这意味着即使在资源受限的环境下,也能运行这个拥有80.3亿参数的强大模型,实现高效的自然语言处理。该模型免费用于非商业用途,非常适合研究人员、开发者和小型企业。

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF主要功能

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF的主要功能是进行自然语言处理,包括但不限于文本生成、问答、文本摘要等。它可以应用于多种场景,例如智能客服、内容创作辅助、企业知识管理等,帮助用户更高效地处理文本信息。

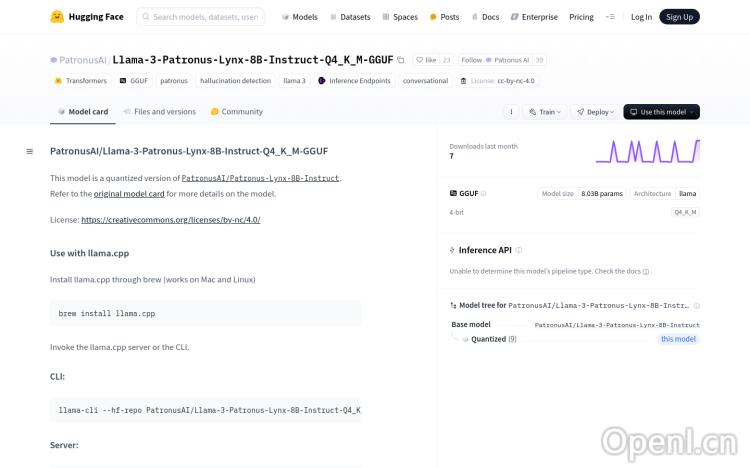

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF如何使用

该模型主要通过llama.cpp进行使用。你可以通过brew安装llama.cpp(适用于Mac和Linux系统),然后使用命令行工具llama-cli进行推理。 更高级的用户可以搭建llama-server来部署推理服务。详细的使用方法可以参考llama.cpp的官方仓库。

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF产品价格

该模型本身是免费的,可用于非商业用途。但是,使用过程中可能需要支付服务器和计算资源的费用,具体取决于你的使用方式和规模。

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF常见问题

这个模型的性能如何?与其他大型语言模型相比怎么样? 由于模型采用了4位量化,性能上会有一些损失,但考虑到其低资源需求,其性价比很高。具体性能表现取决于任务和数据集。建议进行实际测试以评估其在特定应用场景下的表现。

如何解决llama.cpp安装或运行过程中遇到的问题? 遇到问题可以参考llama.cpp的官方文档或社区寻求帮助。许多常见问题以及解决方案都可以在其GitHub仓库中找到。

该模型的商业用途授权如何? 该模型目前仅允许用于非商业用途。如果需要用于商业用途,请咨询模型提供方PatronusAI。

Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF官网入口网址

https://huggingface.co/PatronusAI/Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF

OpenI小编发现Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF网站非常受用户欢迎,请访问Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF网址入口试用。

数据评估

本站OpenI提供的Llama-3-Patronus-Lynx-8B-Instruct-Q4_K_M-GGUF都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 13日 上午11:12收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号