RL4VLM官网

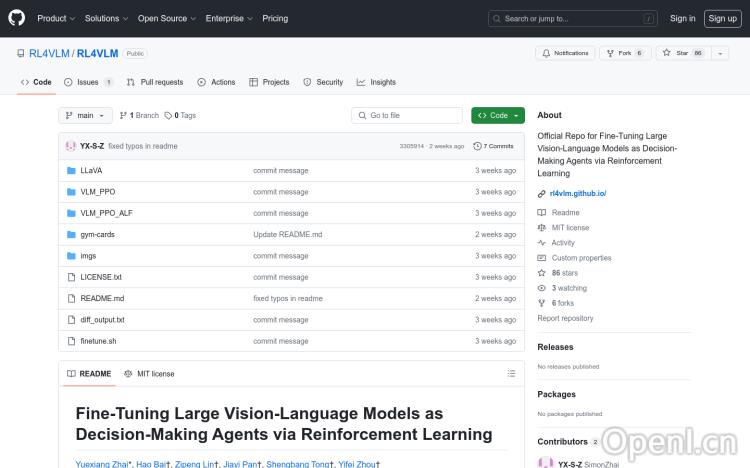

RL4VLM是一个开源项目,旨在通过强化学习微调大型视觉-语言模型,使其成为能够做出决策的智能代理。该项目由Yuexiang Zhai, Hao Bai, Zipeng Lin, Jiayi Pan, Shengbang Tong, Alane Suhr, Saining Xie, Yann LeCun, Yi Ma, Sergey Levine等研究人员共同开发。它基于LLaVA模型,并采用了PPO算法进行强化学习微调。RL4VLM项目提供了详细的代码库结构、入门指南、许可证信息以及如何引用该研究的说明。

RL4VLM是什么?

RL4VLM是一个开源项目,它通过强化学习来微调大型视觉-语言模型(例如LLaVA),使其能够像智能代理一样进行决策。简单来说,它让原本只能理解和生成文本的模型,学会根据图像和文本信息做出更有效的行动选择。这个项目由多位来自学术界和工业界的知名研究人员共同开发,并提供了完整的代码库、使用指南和示例,方便研究人员和开发者使用。

RL4VLM的主要功能

RL4VLM的主要功能是利用强化学习算法(PPO)来训练视觉-语言模型,使其具备决策能力。它提供了两个主要的强化学习环境:GymCards(卡牌游戏环境)和ALFWorld(虚拟世界环境),并针对这两个环境提供了相应的代码和配置。此外,它还提供了修改版的LLaVA模型,以及详细的训练流程和教程,帮助用户快速上手。

如何使用RL4VLM?

使用RL4VLM需要一定的机器学习和深度学习基础。首先,你需要从GitHub下载项目代码,并根据提供的指南设置好相关的conda环境。然后,你需要准备一个预训练的SFT (Supervised Fine-Tuning) 检查点,作为RL训练的起点。接下来,你可以选择GymCards或ALFWorld环境,并根据提供的模板脚本和配置文件,配置训练参数(例如GPU数量、训练步数等),运行训练过程。训练完成后,你将得到一个经过强化学习微调的视觉-语言模型,它具备更强的决策能力。

RL4VLM的产品价格

RL4VLM是一个完全开源的项目,因此它是免费使用的。

RL4VLM的常见问题

RL4VLM对硬件的要求是什么? RL4VLM需要较高的计算资源,建议使用具有多个GPU的服务器进行训练。具体的硬件需求会根据模型大小和训练参数而有所不同。

如何选择合适的SFT检查点? 选择合适的SFT检查点对于RL训练至关重要。建议选择在大型数据集上训练的、性能良好的检查点。项目文档中提供了部分建议的检查点,用户也可以尝试使用自己训练的检查点。

训练过程中遇到错误怎么办? 项目文档中提供了详细的调试指南和常见错误解决方案。如果遇到无法解决的问题,可以参考文档或者在项目GitHub页面上提Issue寻求帮助。

RL4VLM官网入口网址

https://github.com/RL4VLM/RL4VLM

OpenI小编发现RL4VLM网站非常受用户欢迎,请访问RL4VLM网址入口试用。

数据评估

本站OpenI提供的RL4VLM都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由OpenI实际控制,在2025年 1月 16日 下午6:42收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,OpenI不承担任何责任。

粤公网安备 44011502001135号

粤公网安备 44011502001135号