AIGC动态欢迎阅读

内容摘要:

700个开发硬件免费申请➕现金大奖!生成式 AI、机器人 AI、PC AI 三大赛道!AMD Pervasive AI 开发者挑战赛报名火热进行中,扫码了解详情并报名~导读本文是知乎作者绝密伏击分享整理的MoE大模型相关知识,文内系统性地介绍了混合专家模型(MoE),并对 MoE 的高效训练方法,以及如何提升训练和 Fine-Tuning 的效果进行了详细介绍。

原文地址:

https://zhuanlan.zhihu.com/p/677638939

本文只做学术分享,如有侵权,联系删文。GPT-4是8个2200亿MoE模型

GPT-4远不止1万亿,甚至,还是8个2200亿参数组成的混合专家模型(MoE)。

2023年6月,美国知名骇客George Hotz在接受采访时透露,GPT-4由8个220B模型组成。这么算来,8 x 220B = 1.76万亿。就连PyTorch的创建者Soumith Chintala对此也深信不疑。

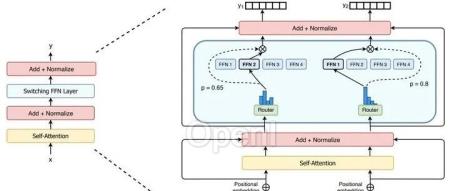

下面这张8头怪,看起来就像现在的GPT-4。MoE 应用于大模型,GPT-4并不是第一个。在2022年的时候,Google 就提出了MoE大模型Switch T

原文链接:群魔乱舞:MoE大模型详解

联系作者

文章来源:算法邦

作者微信:allplusai

作者简介:「算法邦」,隶属于智猩猩,关注大模型、生成式AI、计算机视觉三大领域的研究与开发,提供技术文章、讲座、在线研讨会。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号