AIGC动态欢迎阅读

原标题:今日arXiv最热NLP论文:Meta重磅,为训练数据打上烙印,以判断是否被大模型所用

关键字:水印,模型,放射性,数据,文本

文章来源:夕小瑶科技说

内容字数:11408字

内容摘要:

夕小瑶科技说 原创编辑 | 谢年年为了将LLMs打造类想要的样子,通常需要收集大量数据微调模型。在LLMs时代之前,众包是获取标注数据的主要方式。

自从LLMs出来后,研究者们探索出可以从强大的模型如Bard、ChatGPT或Claude中生成合成数据微调自己的模型,相比众包更加省时省力省钱。

但这一过程涉及到了使用其他模型生成的数据,可能会引发版权和知识产权的问题。例如,如果一个模型被用来生成训练数据,而这些数据又被用来训练另一个模型,那么后者是否是对前者的派生作品?

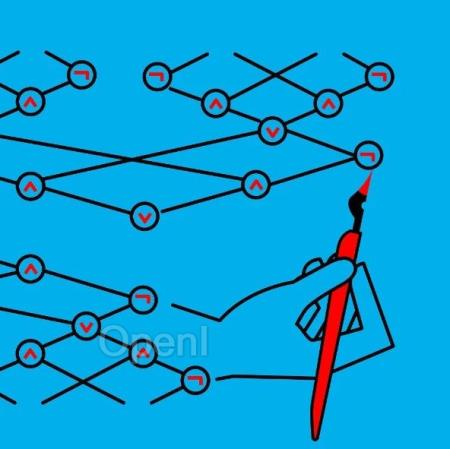

为了追根溯源,可以像图片版权保护一样为LLM的输出打上水印(watermarking),以此来检测合成数据,极大的促进了大模型的安全防护。

最近关于LLM水印技术的文章很多,今天介绍的这篇文章来自Meta,它并没有探讨如何在保障输出质量的情况下为LLM打水印,而是另辟蹊径,研究水印文本的“放射性”——即水印文本被用作微调数据时会发生什么呢?对模型的潜在“污染”能力有多大?

论文标题:Watermarking Makes Language Models Radioactive

前置知识考虑到有些童鞋对水印技术不太了解

原文链接:今日arXiv最热NLP论文:Meta重磅,为训练数据打上烙印,以判断是否被大模型所用

联系作者

文章来源:夕小瑶科技说

作者微信:xixiaoyaoQAQ

作者简介:更快的AI前沿,更深的行业洞见。聚集25万AI一线开发者、互联网中高管和机构投资人。一线作者来自清北、国内外顶级AI实验室和大厂,兼备行业嗅觉与报道深度。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...

粤公网安备 44011502001135号

粤公网安备 44011502001135号